RAG管道优化:大容量 SSD与CXL内存技术

问题意识

RAG pipeline optimization leveraging HC SSD and CXL memory

Adam Manzanares, Hui Qi, Arun George – GOST, NAND AE

Samsung Semiconductor

背景介绍

随着AI 和 ML 技术的快速发展,RAG(检索增强生成)已成为增强大型语言模型能力的关键技术。然而,随着数据量的爆炸式增长,RAG系统面临着严峻的存储性能瓶颈和内存资源浪费问题。您是否曾遇到过这样的困境:向量数据库在持续写入时性能急剧下降?内存资源在数据处理峰值后长期闲置?

本文将深入探讨如何通过大容量SSD和CXL内存技术来解决这些挑战。通过分析RAG管道的完整存储需求架构,探讨FDP(灵活数据放置)技术如何优化SSD性能,以及CXL内存池化技术如何实现资源的动态分配,从而显著提升RAG系统的整体性能和成本效益。

阅读收获

- 掌握RAG管道的完整存储需求架构,理解模型生命周期存储与运行时存储的具体构成。

- 深入了解FDP技术原理,学习如何通过智能数据放置减少写放大效应,优化存储性能。

- 理解CXL内存网络技术,学习如何实现内存资源的精确实时调配,提升资源利用率。

- 学习软硬件协同优化策略,了解如何通过HC SSD和CXL内存技术降低RAG系统总拥有成本。

开放性问题

- FDP技术的实际部署挑战:在现有的RAG系统中集成FDP技术会遇到哪些兼容性和性能调优问题?

- CXL内存池化的性能监控要求:实现内存资源的动态伸缩对系统性能监控提出了怎样的实时性要求?这会带来哪些额外的性能损耗?

- 内存解耦的经济性分析:CMM-D方案在不同容量配置下的$/GB成本变化规律是什么?为什么图示中不同容量的单位成本保持在同一量级?

👉 划线高亮 观点批注

Main

人工智能(AI)和机器学习(ML)作为一股强大的变革力量,正在从三个关键维度深刻地影响着世界:

-

经济投入巨大: 市场正在向AI基础设施投入巨额资金。

-

数据需求爆炸: AI的发展,特别是大型语言模型(LLM),正驱动着数据集规模的空前增长。

-

商业价值显现: 生成式AI已经不再是概念,它在IT、数据分析、内容创作等多个领域展现出明确的投资回报率(ROI),证明了其商业可行性。

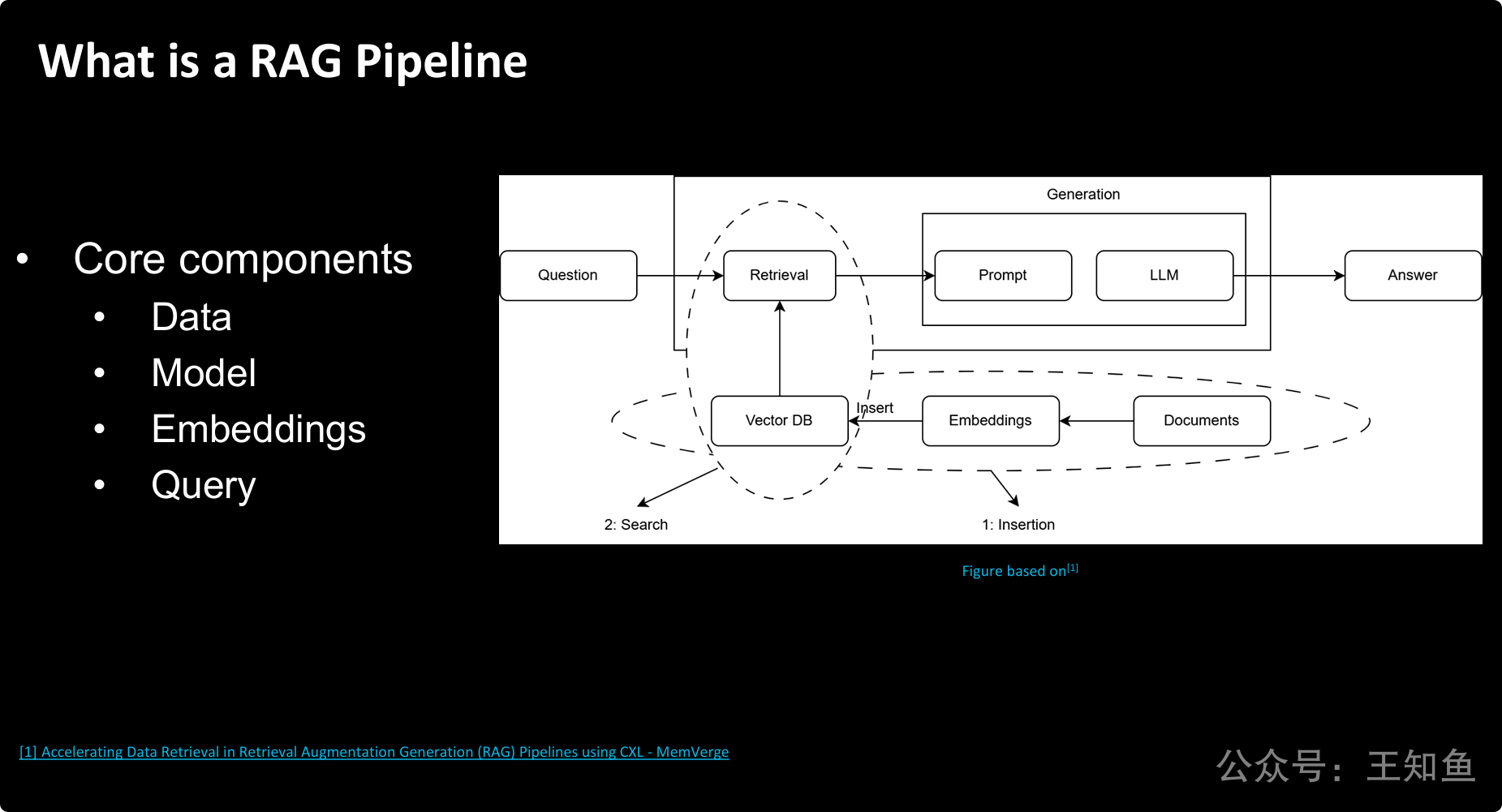

RAG(检索增强生成)技术的工作原理。

RAG是一种将信息检索(Retrieval) 和文本生成(Generation) 相结合的技术框架,其目的是让大型语言模型(LLM)能够利用外部知识库来回答问题,从而解决LLM知识陈旧、容易产生幻觉等问题。

其核心思想可以概括为两个步骤:

-

“先查后答”:当面对一个问题时,系统不直接让LLM作答,而是先去一个专门的知识库(向量数据库)中检索(Retrieve)最相关的信息。

-

“带着答案去作答”:将检索到的相关信息和原始问题一起打包,作为更丰富的上下文(Context)提供给LLM,引导它生成(Generate)一个更准确、更具事实依据的答案。

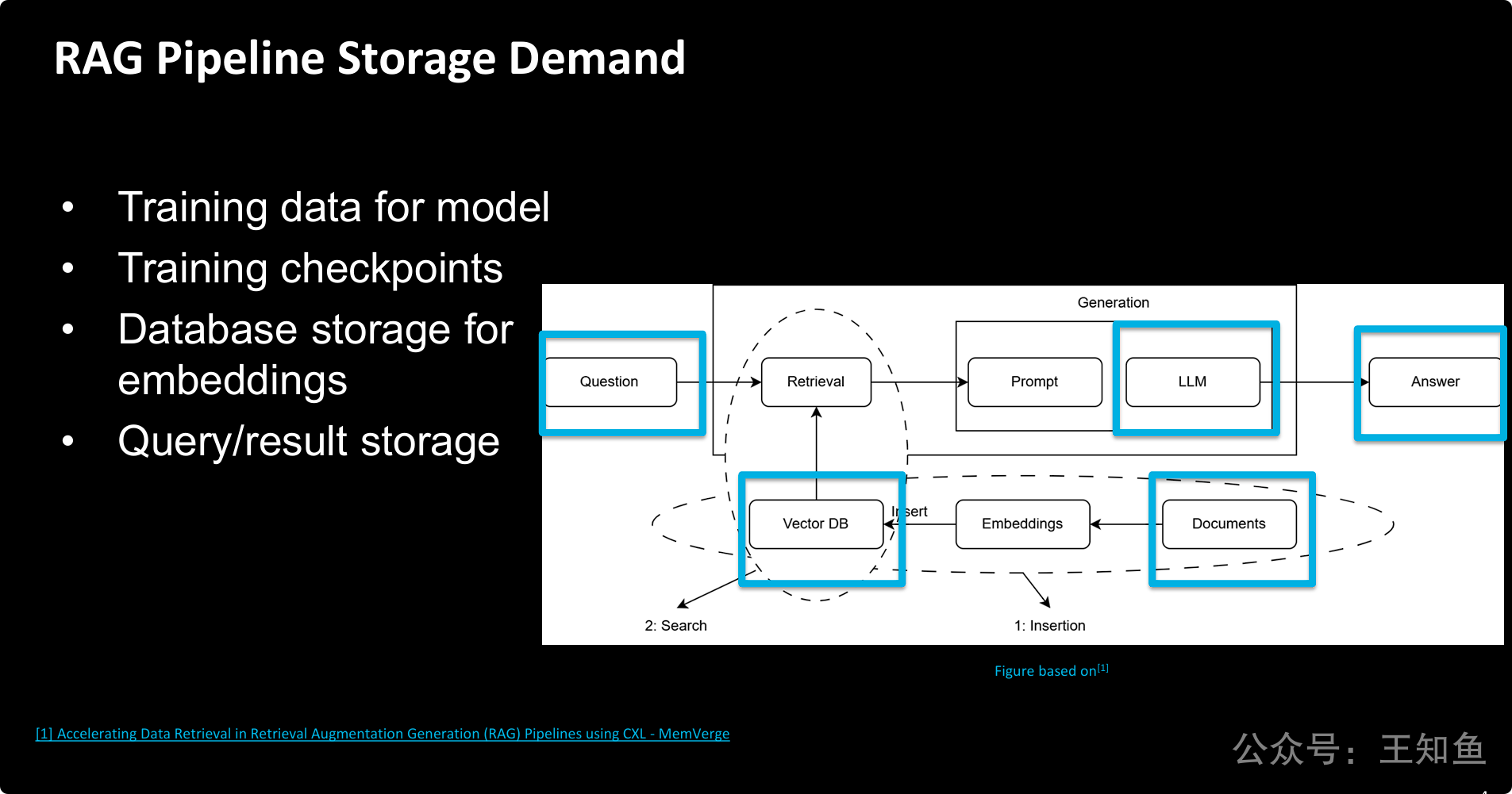

一个完整的RAG解决方案所产生的存储需求是多方面的,不仅限于RAG流程本身,还包括其依赖的底层模型的全生命周期。

这张幻灯片将RAG的存储需求分解为两大类:

-

模型生命周期存储: 包括训练LLM所需的海量原始数据和在训练过程中产生的大量模型检查点。这部分是RAG系统的基础,通常是存储需求的“大头”。

-

RAG管道运行时存储: 包括用于检索的知识库(原始文档和向量数据库)以及系统运行时产生的交互数据(用户查询和模型答案)。

对于RAG本身来讲,存储海量外脑数据的嵌入式检索信息,需要高性能持久化存储解决方案(NVMe-SSD)。

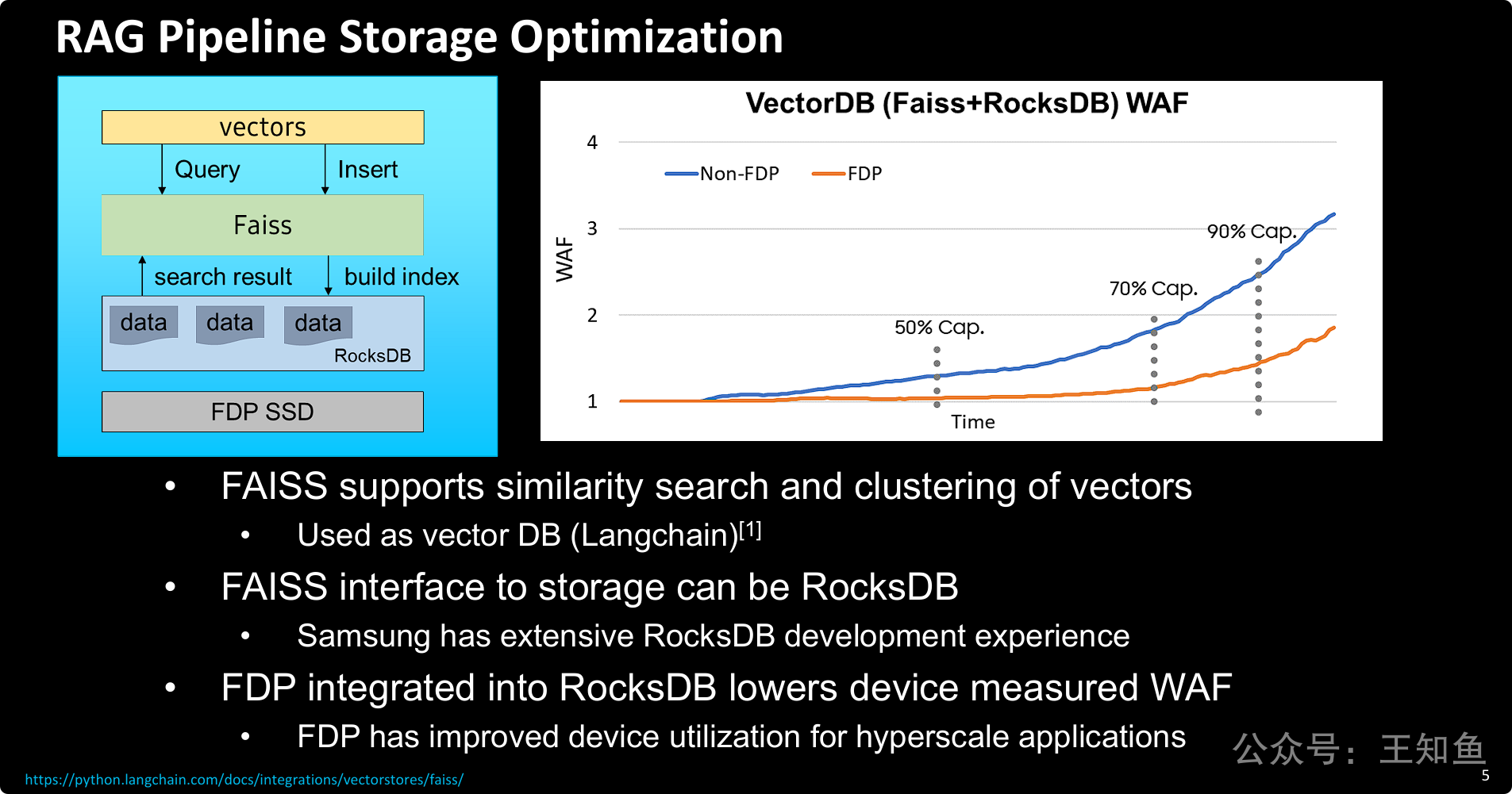

通过采用“Faiss + RocksDB + FDP SSD”这一软硬件协同优化的技术栈,可以显著解决RAG管道中向量数据库的存储性能瓶颈。

-

问题: 传统基于SSD的向量数据库(如Faiss on RocksDB)在数据量持续写入、硬盘容量占用率升高时,会面临严重的写放大(WAF)问题,导致性能下降和SSD寿命缩短。

-

解决方案: 引入FDP(灵活数据放置)技术,并将其与上层存储引擎(RocksDB)进行深度整合。FDP允许软件更精细地控制数据在SSD内部的物理布局,从而减少了SSD内部不必要的数据迁移。

-

效果验证: 实验数据明确证明,与未使用FDP的方案相比,FDP方案可以将大容量下的WAF降低近一半,极大地优化了存储效率和耐久性。这对于需要处理海量向量数据并进行频繁更新的RAG应用场景至关重要。

1. FADU:FDP多命名空间实验:提升SSD性能

- 主要内容:介绍了FDP(灵活数据放置)技术如何通过智能数据放置优化SSD性能,特别是在多租户和混合工作负载环境中。FDP支持多命名空间隔离,减少“噪声邻居”效应,优化垃圾回收,简化管理,并提高性能和耐用性。

2. Samsung:FDP +CacheLib 改善写放大与时延

- 主要内容:探讨了在CacheLib中集成FDP技术的研究方法和结果。FDP通过用户自定义数据放置策略,显著提升系统性能,降低写放大因子(WAF),并具有良好的可扩展性和灵活性。

3. KIOXIA:灵活数据放置(FDP)- 存储架构师必知的技术

- 主要内容:深入探讨了FDP技术如何通过数据分组和灵活放置减少写放大效应,优化存储性能。文章还提供了FDP的配置与调优建议,以及使用中的注意事项。

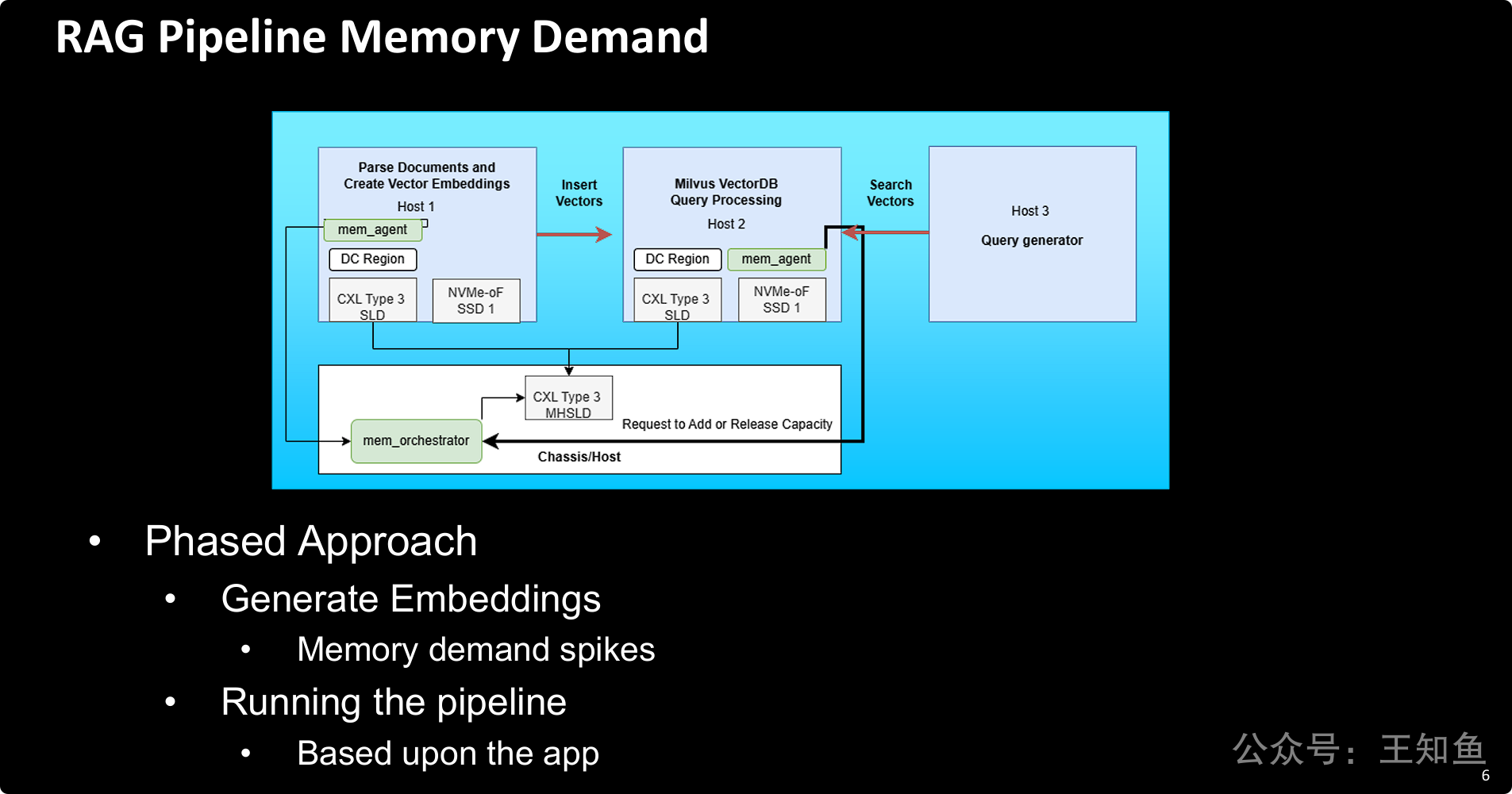

RAG系统的内存需求不是恒定的,而是呈现出显著的阶段性、动态性和突发性特征,这给传统的固定内存分配方式带来了挑战。

-

需求剖析: RAG的生命周期可分为两个内存需求差异巨大的阶段:

-

数据处理阶段: 会产生可预见的、巨大的内存需求峰值。

-

在线服务阶段: 内存需求是动态变化的,取决于实时应用负载。

-

-

架构性解决方案: 为了应对这种挑战,PPT提出了一种基于CXL技术的内存池化(Memory Pooling)和资源解耦的先进架构。通过

mem_orchestrator和共享CXL内存设备(MHSLD),系统可以根据每个主机(数据处理、向量数据库)在不同阶段的实际需求,动态地、按需分配和回收内存资源。 -

目标: 这种架构的目标是实现资源的极致弹性,避免为满足短暂的内存峰值而造成服务器资源的长期闲置和浪费,从而显著提升整个RAG系统的资源利用率和成本效益。

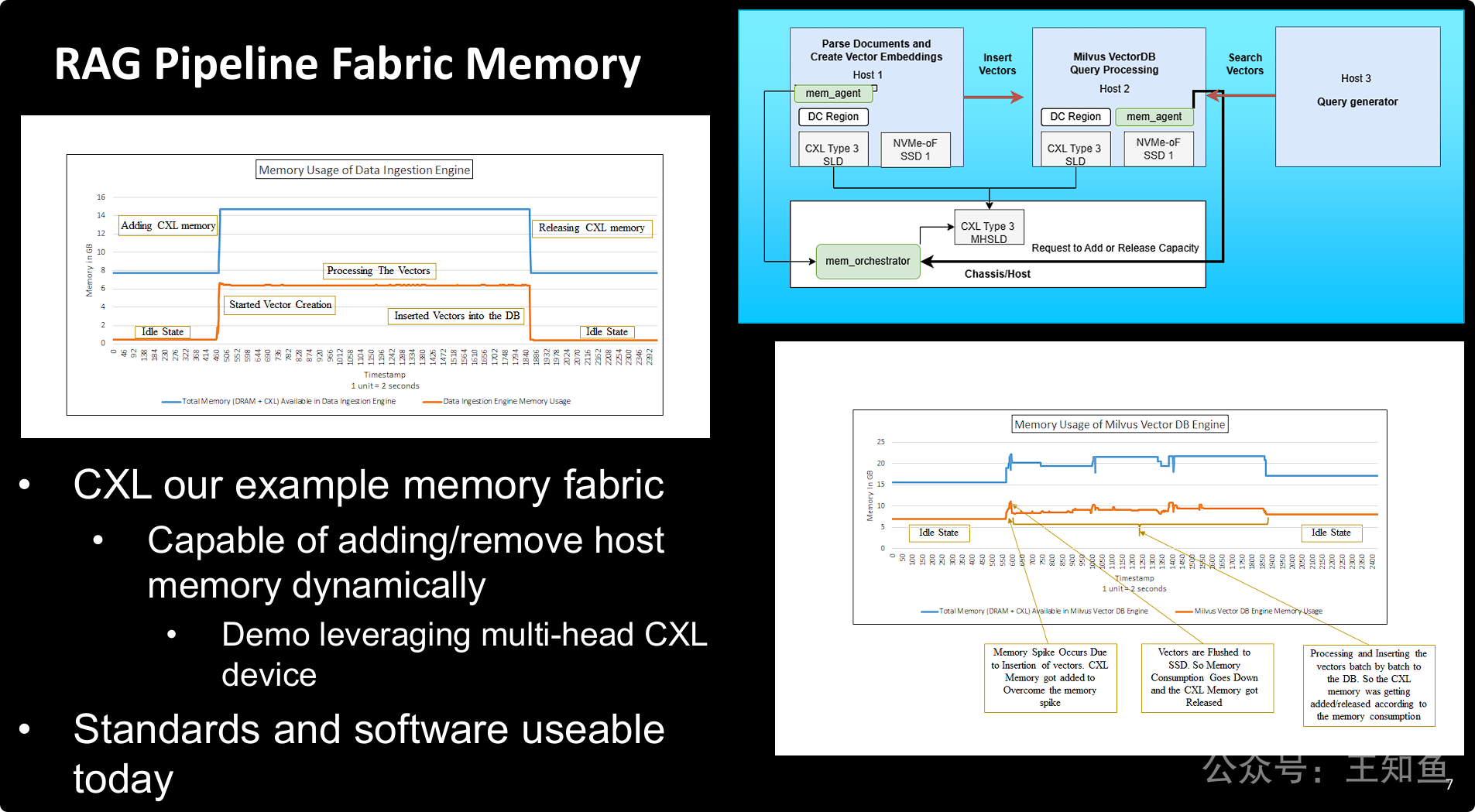

通过CXL内存网络(Memory Fabric)技术,可以实现对RAG管道中各个组件内存资源的精确实时调配,从而极大地提升资源利用率。

通过两个真实的性能图表 “证明” 了上一张PPT中架构的有效性:

-

按需分配: 无论是面对数据处理任务的一次性、大幅度的内存峰值,还是向量数据库服务持续、小幅波动的内存需求,CXL内存池化方案都能够精确、自动地按需分配和回收内存。

-

避免资源浪费: 传统架构下,服务器必须按照峰值需求来配置物理内存,导致在大部分时间里资源闲置。而CXL内存网络方案则完美解决了这个问题,确保内存资源在需要时才被分配,用完后立即归还到共享池中,供其他任务使用。

之前只了解CXL3.0 可实现 Mem Pooling,此处介绍的mem动态伸缩,还是头一回听说,这对系统性能监控实时性要求很高,可能会造成额外的性能损耗。

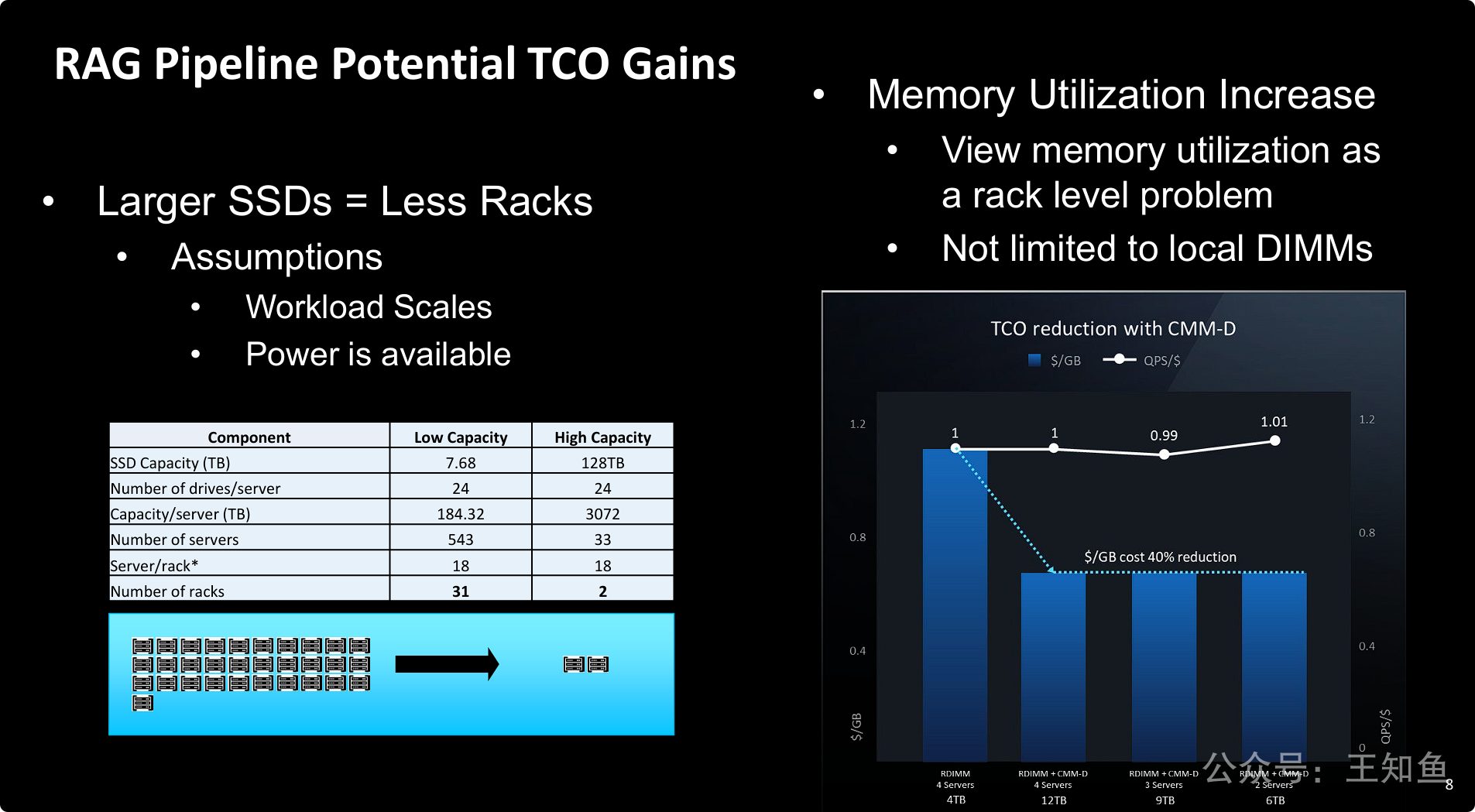

RAG管道降低总拥有成本(TCO)存在两大有效途径:存储硬件的整合与内存资源的解耦。

-

物理层面的降本 (硬件整合): 通过采用单盘容量更大的SSD,可以急剧减少所需的服务器和机柜数量,直接节省数据中心的空间、电力和冷却成本。这是一个简单而直接的“少即是多”的策略。

-

资源层面的降本 (内存解耦): 通过引入CXL等内存互联技术,将内存从服务器中“解放”出来,形成一个可共享的、动态分配的资源池。这能将昂贵的内存成本降低约40%,并允许用更少的服务器支撑更大的内存需求,从而实现服务器整合,进一步削减硬件、软件许可和运维成本,同时保持高性能。

这张片子存在2个盲点,指出如下:

- 左侧大容量SSD的节点、机柜数量估算,缺少一个总容量前提,按表格

单节点容量 ✖️ 节点数,大致得出存储裸容量为100PB- 右侧CMM-D 内存解耦扩容,RDIMM+CMM-D,在不同内容容量下的 $/GB,应该是不一样的,逻辑上推演CMM-D容量越大,TCO应该更低,而图示都是一个量级;至于单位成本的QPS指标,应该是低于基线RDIMM方案,否则采用CMM方案,单位性能的成本,反而是增加了。