AI向量搜索新纪元:KIOXIA AiSAQ™如何用SSD颠覆DRAM瓶颈?

问题意识

KIOXIA AiSAQTMTechnology

All-in-storage ANNS Algorithms Optimize VectorDB Usability within a RAG System

背景介绍

随着AI大模型和RAG(检索增强生成)技术的飞速发展,向量数据库已成为构建智能应用不可或缺的核心组件。然而,您是否曾被传统向量搜索架构中DRAM的容量限制和高昂成本所困扰?在追求更大规模、更高效能的AI部署时,DRAM往往成为系统扩展性的瓶颈,让许多创新构想止步于成本与性能的权衡。

KIOXIA(铠侠)推出的AiSAQ™(All-in-Storage ANNS with Product Quantization)技术,正试图打破这一僵局。它提出了一种“全闪存”的ANNS(近似最近邻搜索)解决方案,旨在将海量向量数据及其索引结构从昂贵的DRAM转移到成本更低、容量更大的SSD上。这不仅有望大幅降低AI基础设施的总体拥有成本(TCO),更将为大规模RAG和语义搜索应用开启前所未有的可扩展性。本文将深入探讨AiSAQ™如何通过创新算法,重新定义AI向量搜索的未来。

阅读收获

- 理解AI向量搜索的DRAM瓶颈:深入剖析传统RAG架构中DRAM对向量数据库扩展性的制约,以及其带来的成本挑战。

- 掌握AiSAQ™“全闪存”架构核心:了解KIOXIA AiSAQ™如何通过创新算法实现“近乎零DRAM”占用,将所有关键数据结构迁移至SSD,从而大幅降低介质成本。

- 洞察性能与规模的灵活平衡:理解AiSAQ™如何在不同AI应用场景(如RAG、在线/离线语义搜索)中,提供灵活的性能与规模调优能力,以适应多样化的业务需求。

- 认识多租户部署的经济优势:探索AiSAQ™如何通过消除冷启动延迟和实现超高租户密度,为多租户AI服务提供商带来显著的经济效益和运营效率提升。

开放性问题

- KIOXIA AiSAQ™的“全闪存”ANNS算法在SSD上实现高性能和高可扩展性的具体技术细节是什么?其与DiskANN等混合方案的核心差异和优势体现在哪些方面?

- 考虑到AI算力成本和数据规模的持续增长,AiSAQ™这类“存储中心”的AI基础设施方案,将如何重塑未来的AI应用架构和商业模式?

- 在实际部署中,如何根据不同的业务场景(如实时推荐、大规模知识库问答)精确评估和选择AiSAQ™的性能/规模平衡点,以实现最佳的TCO和用户体验?

👉 划线高亮 观点批注

Main

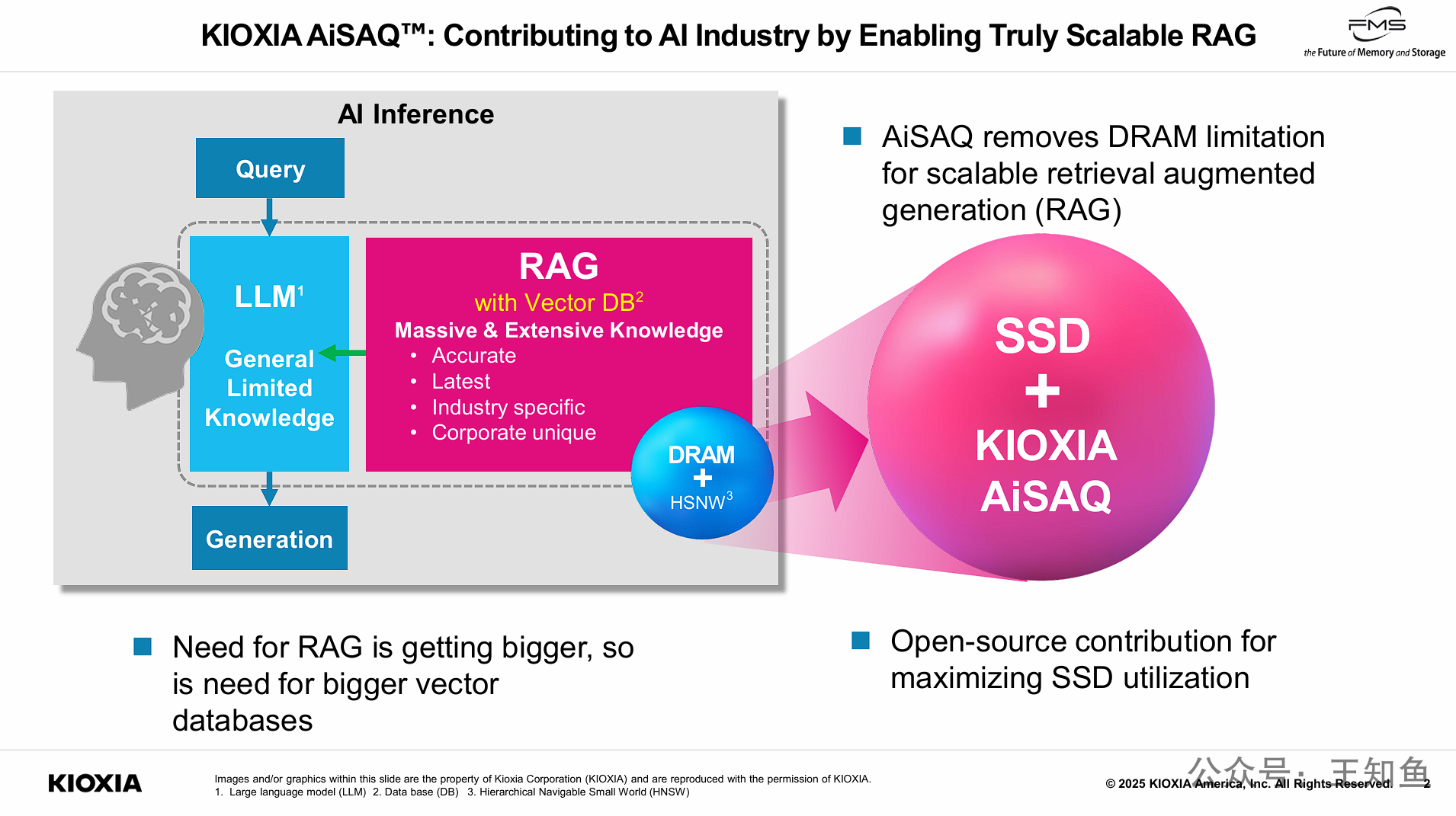

PPT的核心观点是,当前AI领域对RAG(检索增强生成)技术的需求正快速增长,这带动了对更大规模向量数据库的需求。然而,传统的RAG架构严重依赖DRAM来运行向量搜索(如HNSW算法),但DRAM的容量有限且成本高昂,这成为了实现大规模RAG的可扩展性瓶颈。

KIOXIA(铠侠)为此推出了名为AiSAQ™(All-in-Storage ANNS with Product Quantization)的解决方案。该技术的核心优势在于解除了DRAM的限制,允许RAG系统将海量的向量数据库存储在成本更低、容量更大的SSD(固态硬盘)上,并通过AiSAQ技术实现高效检索。

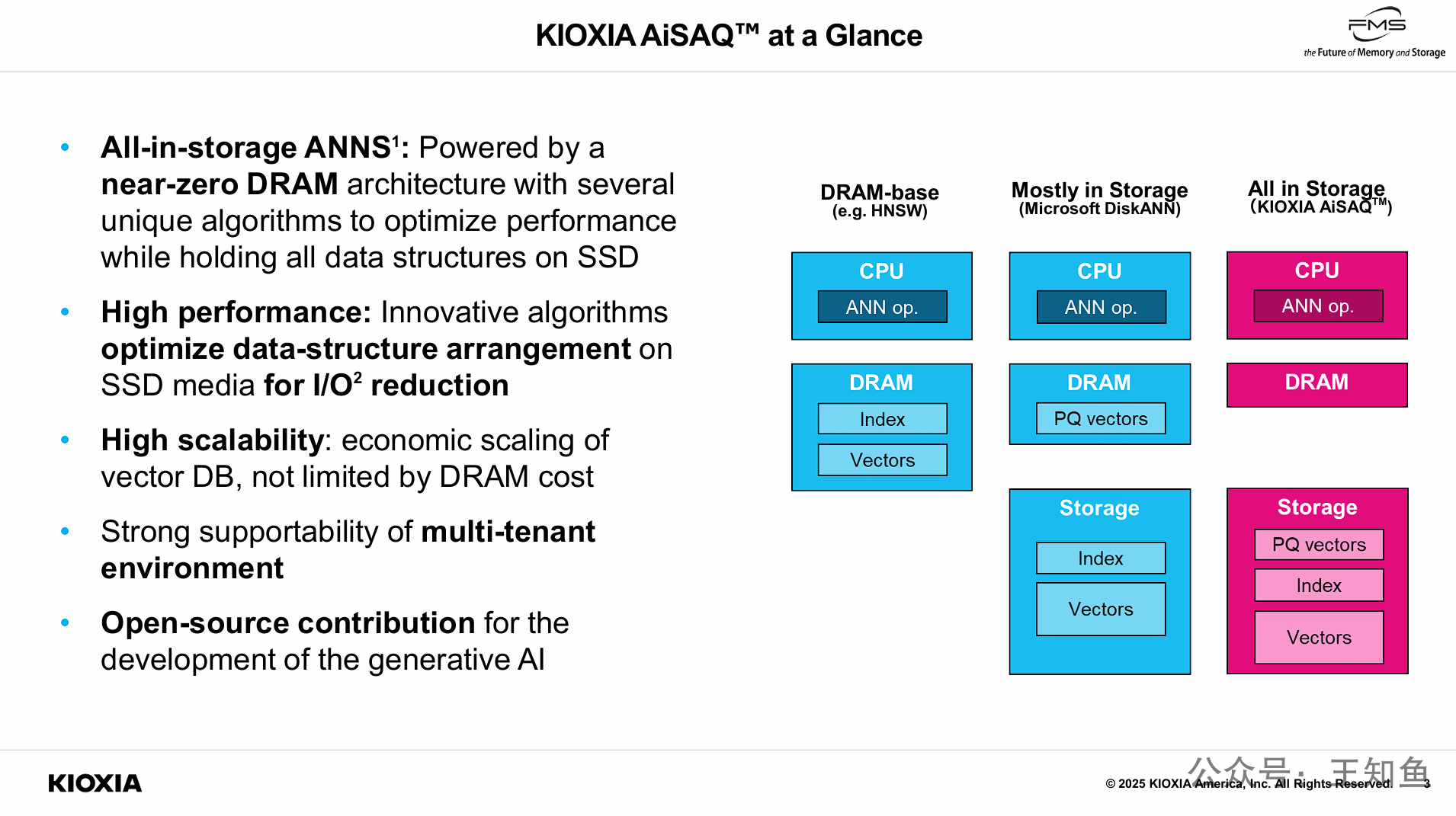

PPT的核心观点是对比并突显KIOXIA AiSAQ™架构的优越性。

它首先将传统的ANN实现(如HNSW)归类为“基于DRAM”的架构,其索引和向量都必须加载到昂贵的DRAM中,因此可扩展性受限。

接着,它展示了像DiskANN这样的“主要在存储中”的混合方法,这种方法将部分数据(PQ向量)保留在DRAM中,而将索引和原始向量放在存储上。

最后,KIOXIA AiSAQ™,将其定义为一种“全在存储中 (All in Storage)”的架构。AiSAQ通过其创新的算法,将包括索引、原始向量和PQ向量在内的所有关键数据结构都移到了SSD上,实现了“近乎零DRAM”的占用。

===

左侧文字内容(AiSAQ的关键特性): 左侧通过五个要点详细描述了KIOXIA AiSAQ™的特性:

-

All-in-storage ANNS¹(全闪存ANNS¹): 由一种“near-zero DRAM architecture”(近乎零DRAM的架构)提供支持。该架构采用多种独特算法来优化性能,同时将所有数据结构都保存在SSD上。

-

High performance(高性能): 创新的算法优化了SSD介质上的数据结构布局,以实现 I/O² 的减少。

-

High scalability(高可扩展性): 实现了向量数据库的经济高效扩展,不再受到DRAM成本的限制。

-

Strong supportability of multi-tenant environment(对多租户环境的强大支持能力)。

-

Open-source contribution for the development of the generative AI(为生成式AI的发展提供开源贡献)。

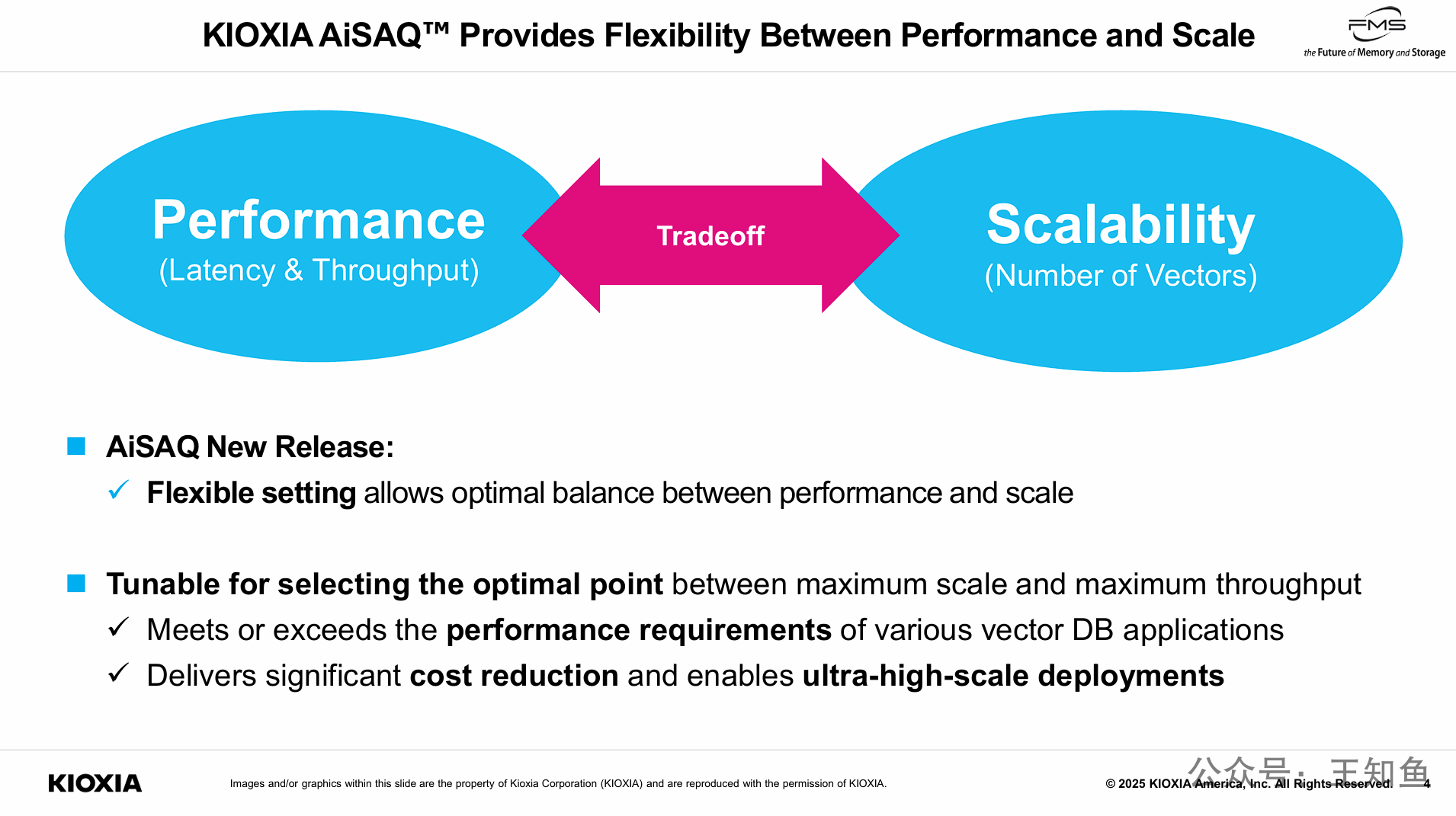

传统向量数据库架构面临一个固有的“权衡”难题:追求高性能(低延迟、高吞吐)通常会限制系统的可扩展性(能处理的向量数量);而追求大规模则往往会牺牲性能。

KIOXIA AiSAQ通过提供“灵活的设置”(Flexible setting)和“可调优”(Tunable)的能力,允许用户可以根据自己应用的具体需求,在“最大规模”和“最大吞吐量”之间找到一个“最佳平衡点”(optimal point)。

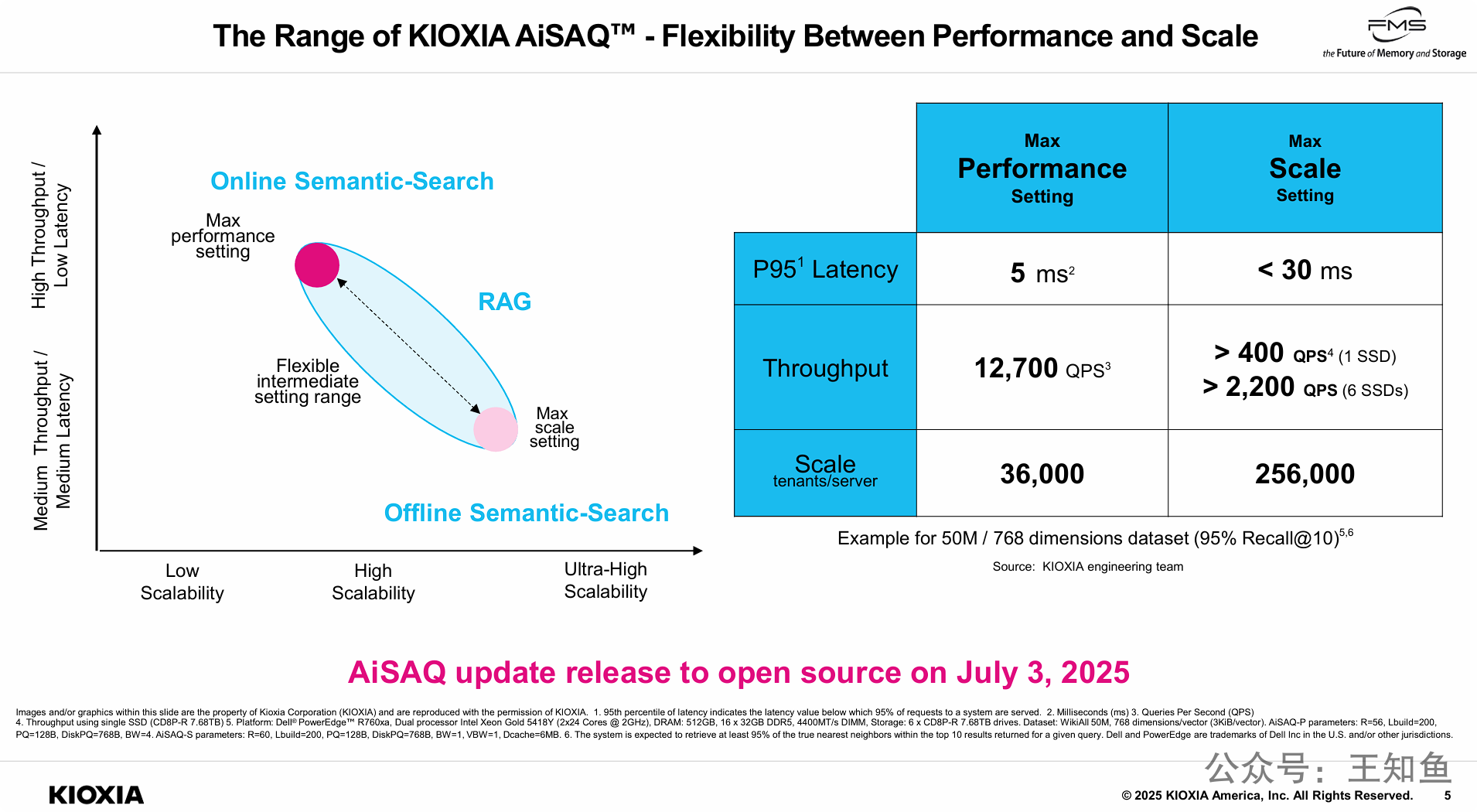

PPT的核心观点是用具体的数据和图表来证明 KIOXIA AiSAQ™ 的灵活性和可调优性。

AiSAQ并非只有一种工作模式,而是提供了一个可配置的范围,允许用户在“性能”和“规模”之间进行权衡和选择:

-

最大性能设置: 专为“在线语义搜索”等低延迟应用优化,可实现极低的5ms P95延迟和高12,700 QPS吞吐量。

-

最大规模设置: 专为“离线语义搜索”或超大规模部署优化,虽然延迟放宽到 <30ms,但单服务器可支持的租户规模(可理解为数据集的数量或隔离度)剧增至256,000,远超性能模式下的36,000。同时,其吞吐量可以随SSD数量线性扩展。

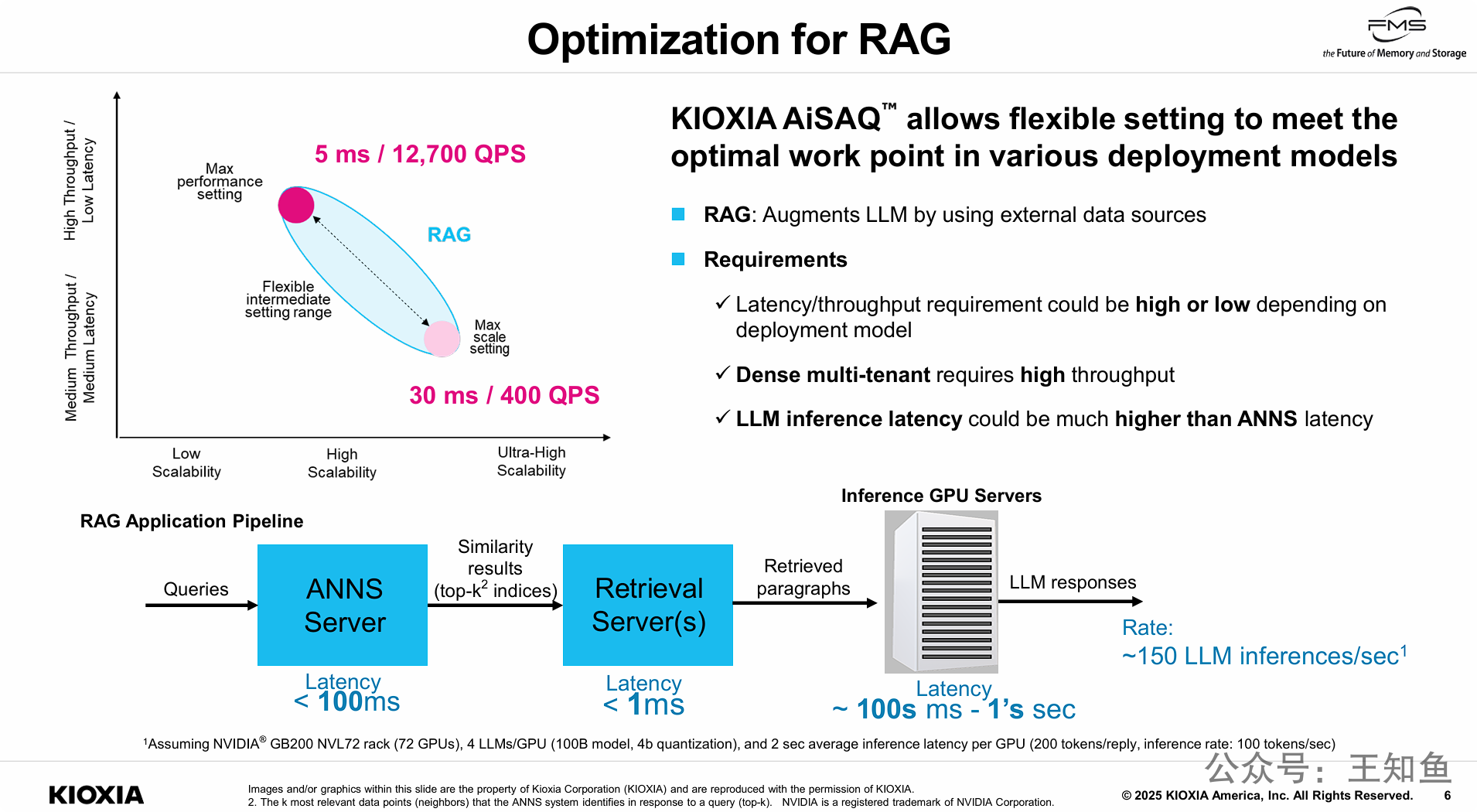

在整个RAG链条中,延迟瓶颈在于LLM的推理(几百毫秒到1秒),而不是ANNS的向量搜索(小于100毫秒)。

这意味着,对于大多数RAG应用而言,并不需要追求ANNS[]()服务器的极限性能(如5ms的超低延迟),因为LLM的延迟要高得多。因此,RAG应用开发者可以在AiSAQ提供的灵活范围内进行调优,适当放宽ANNS的延迟要求(例如到30ms),以换取巨大(且成本更低)的系统可扩展性(规模)。

===

下方的流程图(RAG Application Pipeline - RAG应用管道): 这张图详细分解了RAG应用的延迟构成:

-

Queries (查询):请求的起点。

-

ANNS Server (ANNS 服务器):执行向量搜索,输出“相似性结果 (top-k² 索引)”。此步骤的延迟 (Latency) 预估为 < 100ms (小于100毫秒)。

-

Retrieval Server(s) (检索服务器):根据索引从数据库中抓取原始段落 (Retrieved paragraphs)。此步骤的延迟极低,< 1ms (小于1毫秒)。

-

Inference GPU Servers (推理GPU服务器):接收检索到的段落,由LLM生成最终响应 (LLM responses)。此步骤是延迟的主要瓶颈,延迟 (Latency) 为 ~ 100s ms - 1's sec (约几百毫秒到1秒级别)。

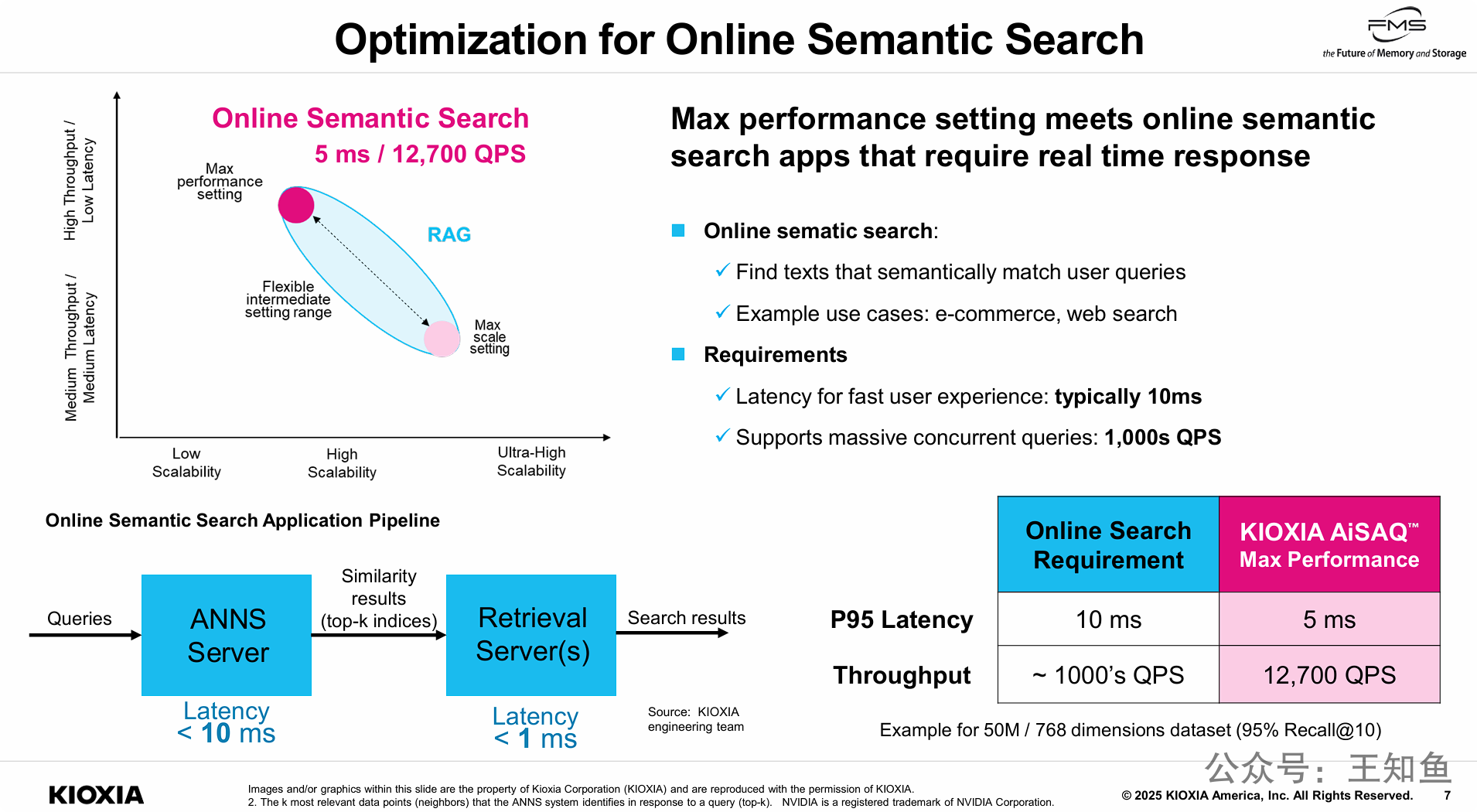

在线语义搜索(如电商、Web搜索)的特点:它需要“实时响应”,因此对延迟(典型要求10ms)和并发吞吐(要求数千QPS)极其敏感。其应用管道中没有缓慢的LLM推理,使得ANNS的搜索延迟成为关键瓶颈。

KIOXIA AiSAQ™在“最大性能”模式下,可以实现:

-

在延迟方面: 5ms,是行业典型要求 (10ms) 的一半,响应速度更快。

-

在吞吐量方面:12,700 QPS,远高于“数千QPS”的行业要求,能支持更大规模的并发查询。

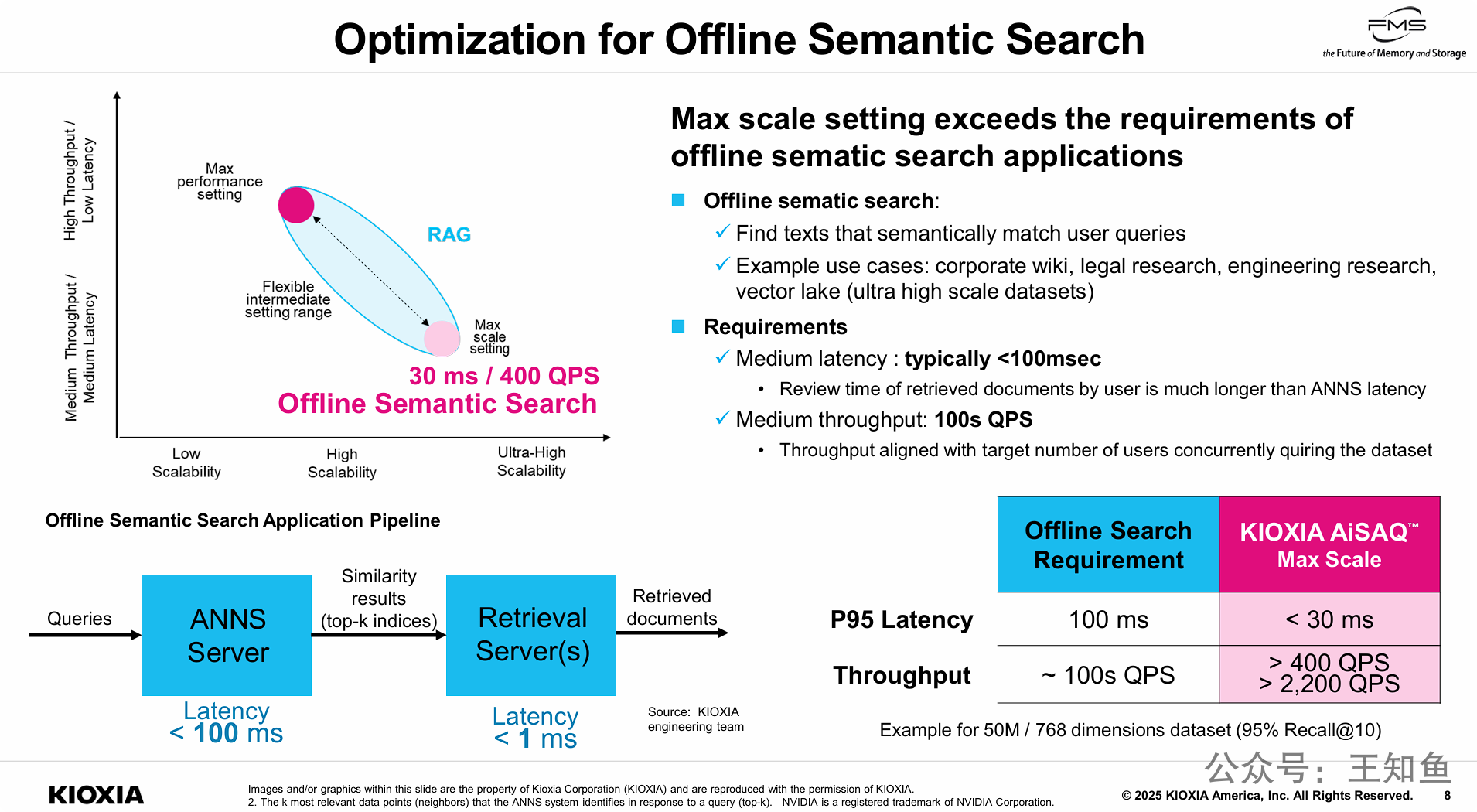

离线搜索(如企业维基、向量湖)的特点:这类应用最关心的是处理“超大规模数据集”(ultra high scale datasets)。由于用户需要花费较长时间(远超毫秒级)来阅读和分析搜索结果,因此这类应用对ANNS的搜索延迟并不敏感,100ms的延迟和数百QPS的吞吐量通常已足够。

KIOXIA AiSAQ™的“最大扩展性策略,可以实现:

-

在延迟方面:< 30 ms,远优于100ms的行业要求。

-

在吞吐量方面: > 400 QPS(单SSD),同样高于“数百QPS”的要求,并且可以随SSD数量扩展。

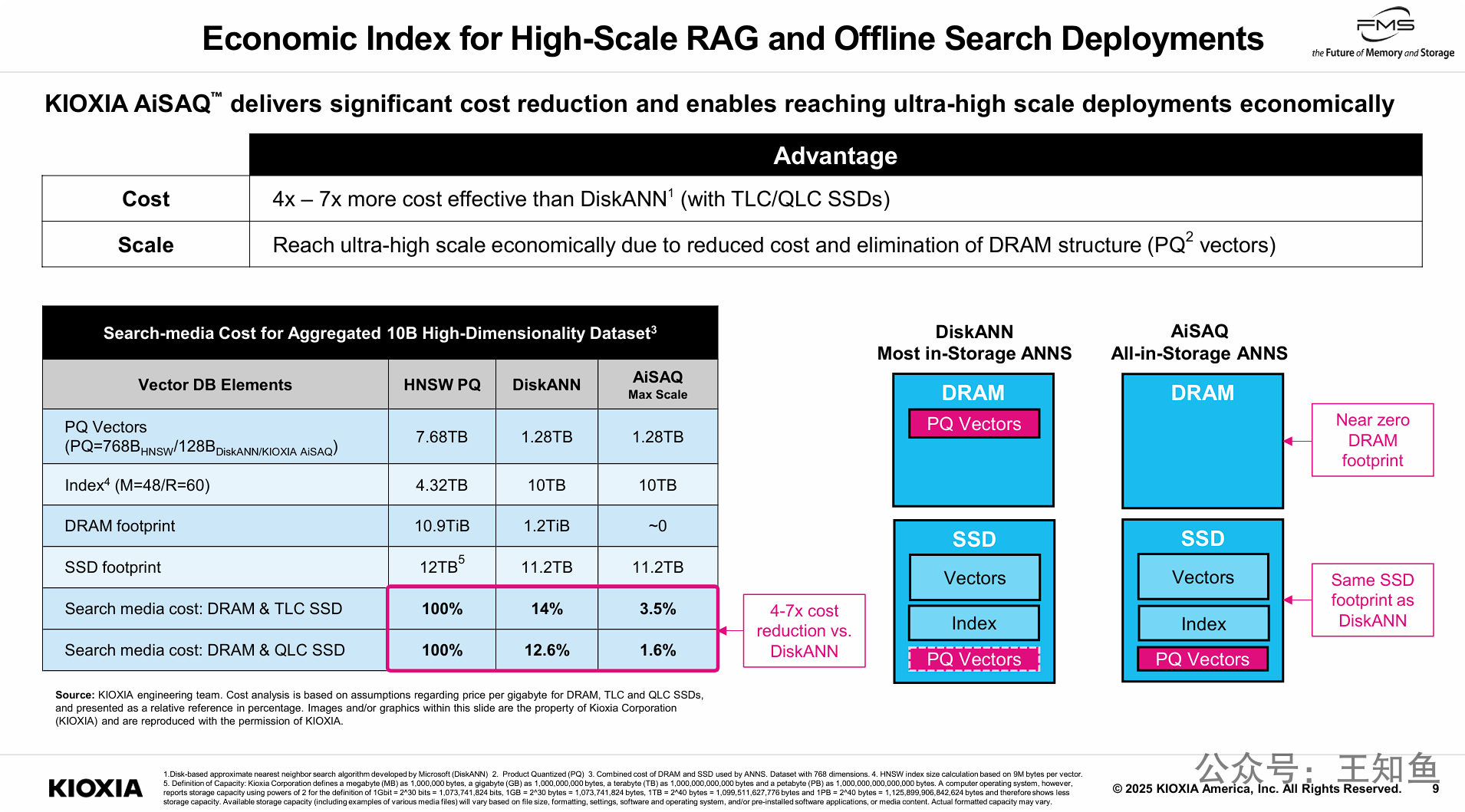

通过量化数据和架构对比,证明KIOXIA AiSAQ™在超大规模部署(如大规模RAG和离线搜索)上的巨大经济优势。

-

竞争对手方案(如DiskANN)虽然将大部分数据放在SSD,但仍必须在昂贵的DRAM中保留PQ向量(在本例中为1.2TB)。

-

AiSAQ的“全闪存”架构通过创新算法,将PQ向量也移到了SSD上,实现了“近乎零DRAM占用”。

-

消除这1.2TB的DRAM占用带来了巨大的成本节约。以100亿数据集为例,AiSAQ的总体介质成本(DRAM+SSD)仅为DiskANN的1/4(TLC)到1/7(QLC)。

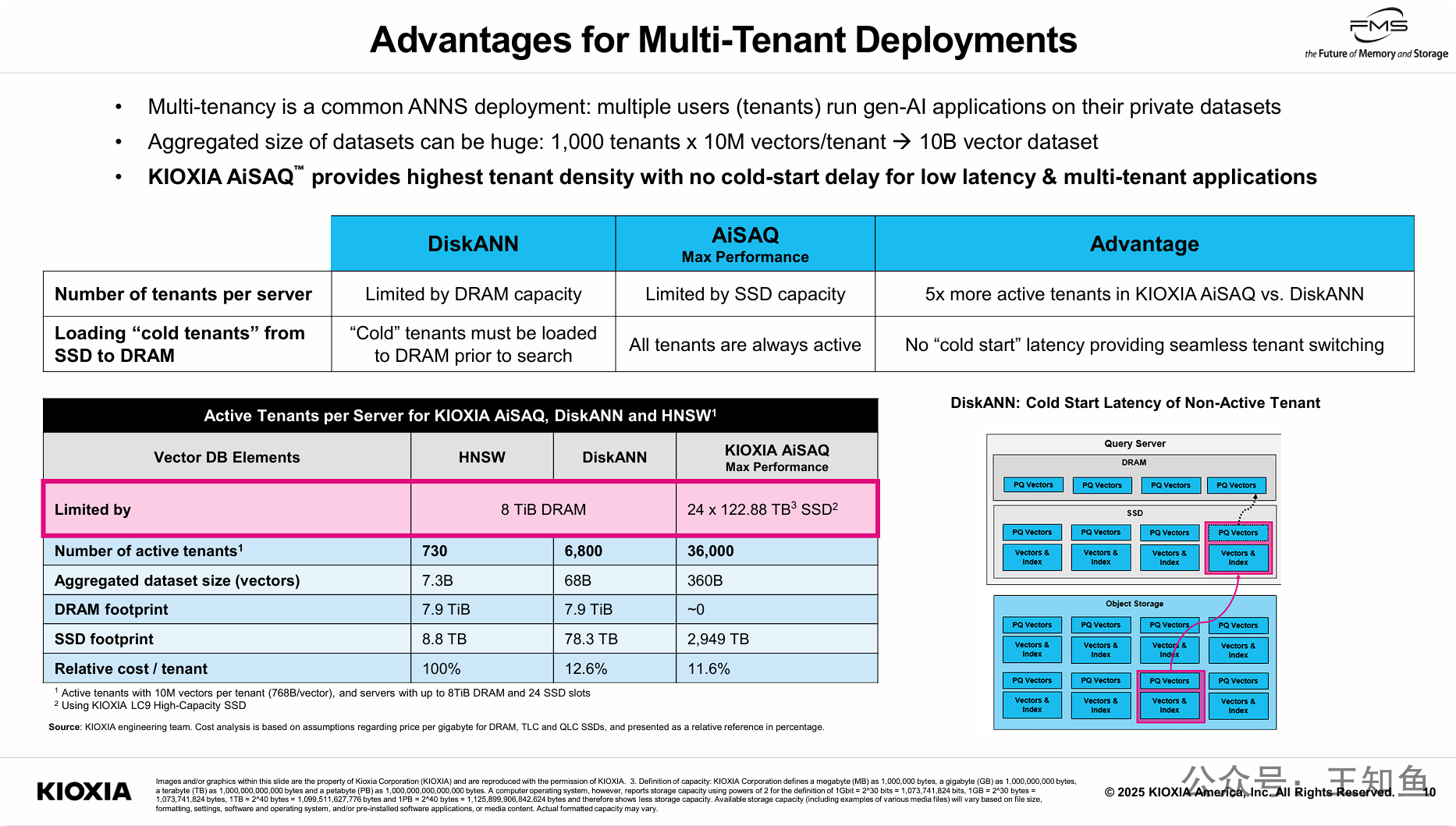

PPT的核心观点是KIOXIA AiSAQ™在多租户部署场景下具有压倒性优势,主要体现在“租户密度”和“冷启动延迟”两个方面。

-

解决了“冷启动”延迟问题: 如图所示,DiskANN这类架构受DRAM容量限制,只能将少量“活跃”租户数据(如PQ向量)放在DRAM中。当访问“冷”租户时,必须从SSD加载数据到DRAM,导致高延迟。而AiSAQ的“全闪存”架构将所有租户数据(包括PQ向量)都放在SSD上,使其“始终活跃”,彻底消除了冷启动延迟,实现了无缝的租户切换。

-

实现了超高租户密度: 由于AiSAQ的瓶颈从昂贵且有限的DRAM(本例中8TiB)转移到了大容量的SSD组(本例中高达2,949 TB),它在同一台服务器上可支持的活跃租户数量是DiskANN的5倍以上(36,000 vs 6,800)。

总结页凝聚了整个演示文稿的核心信息。它强调 KIOXIA AiSAQ™ 是一款 开源的、革命性的“ 全闪存”ANNS算法,其核心创新在于充分利用SSD来替代昂贵的DRAM。

这一创新带来了五大核心优势:高可扩展性、高性能、灵活的(性能/规模)平衡能力、卓越的多租户支持以及对RAG和语义搜索等关键AI应用的普适性。

基于SSD来离线处理RAG工作流的技术报道,自从AI需求爆发以后,屡见不鲜,但KIOXIA 在这篇材料里不论是性能还是容量都超越DRAM方案的实验数据,着实令人惊讶,且一定程度反常识,后续要翻一翻其开源的代码仓库,弄清楚:AiASQ 的实现原理以及和 DiskANN 的核心差异。