AI算力核心:HBM市场格局与未来挑战

问题意识

How AI Growth Will Drive HBM Demand Beyond 2025: Shaping Product Evolution a and Market Dynamics

Ellie Wang/Analyst

随着AI大模型技术的飞速发展,对高性能计算和海量数据处理的需求达到了前所未有的高度。在这场算力竞赛中,高带宽内存(HBM)已成为AI芯片不可或缺的核心组件,其性能直接决定了AI模型的训练效率和推理能力。当前,HBM市场正经历一场剧烈的变革,存储巨头们纷纷加大投入,展开激烈的“军备竞赛”,而NVIDIA、AMD等AI芯片设计者也在不断刷新HBM的规格上限。同时,头部云服务提供商(CSPs)的自研芯片战略,也为HBM市场带来了新的变数。

面对HBM市场的高速增长、技术迭代和复杂的竞争格局,我们不禁要问:HBM将如何重塑存储行业,又将如何影响AI的未来发展?这场由AI驱动的内存革命,又将带来哪些机遇与挑战?本文将深入剖析HBM市场的供给侧、需求侧及商业价值,为您揭示其背后的深层逻辑。

阅读收获

通过本文,您将能够:

- 洞察HBM市场供给侧的竞争态势:了解SK海力士、美光等主要厂商的产能扩张策略,以及HBM4作为下一代决胜关键的技术储备。

- 理解AI芯片对HBM的极致需求:分析NVIDIA、AMD及头部云厂商在AI芯片路线图中,如何通过提升HBM容量和堆叠层数来满足大模型对内存带宽的渴求。

- 掌握HBM如何重塑DRAM市场格局:认识HBM作为高价值产品,其收入占比如何迅速攀升,并颠覆传统DRAM市场的领导地位。

- 思考HBM市场高速增长的潜在风险:探讨HBM供应瓶颈、AI泡沫的担忧,以及数据平台软件层创新在释放数据资产价值中的关键作用。

开放性问题

- 考虑到HBM市场增长率预计在2026年放缓至27%,您认为Agent经济的成熟能否有效重新点燃HBM需求,避免“AI泡沫”的担忧?

- NVIDIA在HBM消耗上占据绝对主导地位,这种高度集中的市场格局对AI产业的长期健康发展是利是弊?云厂商的自研芯片策略能否有效打破这一局面?

- 除了HBM技术本身的演进,您认为在AI大模型时代,存储架构和数据平台软件层还需要哪些关键创新,才能真正释放数据资产的价值?

👉 划线高亮 观点批注

Main

供给侧分析

受AI需求驱动,HBM已成为内存市场的战略核心,头部厂商正在展开激烈的“军备竞赛”,其产能扩张计划的差异将直接决定未来的市场格局。

具体关键信息如下:

-

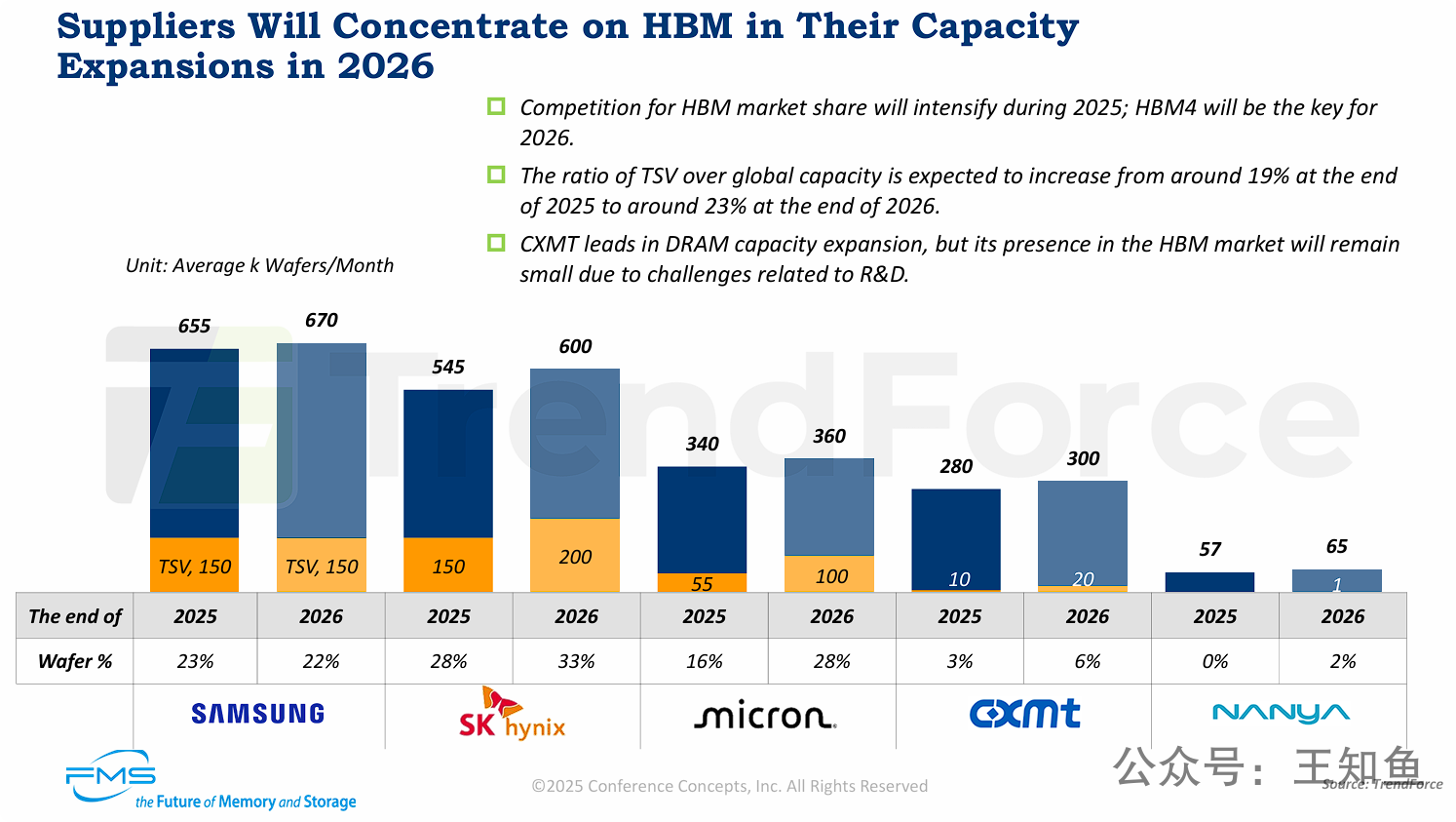

HBM是扩张焦点:2026年,内存行业的主要增量资本和产能将集中投向HBM。整个行业的HBM产能占比将显著提升。

-

SK海力士的领跑与野心:SK海力士是HBM扩产最为激进的厂商,计划在2026年将高达三分之一的总产能用于HBM生产。这一战略决策旨在巩固并扩大其在HBM市场的领先优势。

-

美光的追赶策略:美光通过近乎翻倍的HBM产能扩张(头部厂商中同步增长最大),显示其绝不甘心在这一高增长市场落后的决心,正全力追赶三星和SK海力士。

-

市场格局高度集中:HBM市场是典型的“巨头游戏”,竞争主要在三星、SK海力士和美光之间展开。其他厂商如CXMT和南亚科,由于技术和研发壁垒,短期内难以构成有意义的威胁,这将进一步加剧内存市场的技术和盈利分化。

-

HBM4是下一战场:PPT明确指出HBM4是2026年的决胜关键,暗示厂商们不仅在扩充现有HBM3/HBM3E的产能,更在为下一代产品的量产进行技术和产能储备。

[!note]

TSV (硅通孔) 是HBM生产制造的关键技术,可通过这一指标衡量存储企业在HBM上的产能。SK Hynix 和 Micron 都在积极扩充 TSV产能,预示着下一阶段的HBM 产能竞争,大概率这两家公司会有更亮眼的成绩。CXMT 单月晶圆的产能(300K)已经离Micron不远,但用于HBM的TSV产能仍占比有限,主要受限于新技术研发壁垒。头部厂商逐鹿HBM,CXMT能否在机遇期中开拓D5市场?

HBM市场正在经历总出货量的快速增长,但增长速度预计将从2024年的顶峰开始放缓。在供应商格局方面,SK海力士保持市场主导地位,而美光正迅速扩大其市场份额。

-

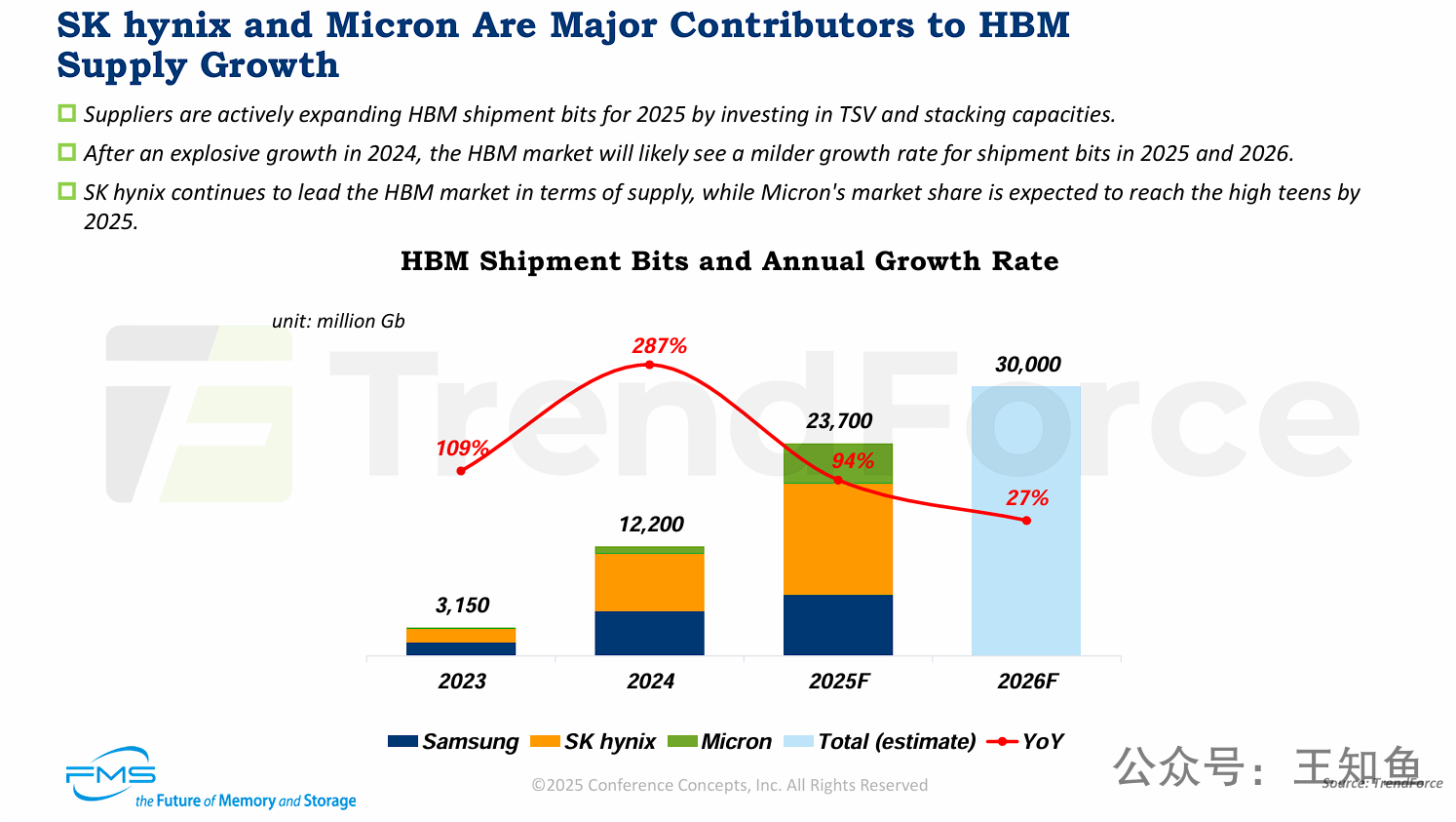

市场高速增长后放缓: HBM市场出货量在2024年迎来了287%的爆发式增长,但预计在2025年(94%)和2026年(27%)增长率将明显减速。

-

SK海力士的领导地位: SK海力士目前是HBM市场供应的绝对领导者,占据最大的市场份额。

-

美光的快速追赶: 美光(Micron)正成为HBM供应增长的重要贡献者,其市场份额预计到2025年将显著提升至15%-19%(high teens)。

-

产能扩张动力: 供应商(如SK海力士和美光)正在通过投资关键技术(如TSV和堆叠)来积极扩大产能,以满足2025年的市场需求。

-

市场总量预测: HBM总出货比特量预计将从2023年的3,150MGb增长至2026年的30,000MGb,四年间增长近10倍。

[!note]

26财年增长率降至27%这一指标值得留意,HBM作为GPU热数据运算的核心载体,一定程度上是衡量AI泡沫的试金石,如果Agent经济能完成价值变现,那么市场对HBM的需求将重新被点燃,如果迟迟不及预期,重复“狼来了”的故事,可能会浇灭热钱的耐心。从软件侧数据平台准备度来看,还远不及预期,David 描述的SoI层(System of Intelligence) 仍然处于脚手架阶段,只有智能数据层准备好,Agent 工具链具备监测、可溯源和安全可信,大量有价值的核心数据宝藏,才会释放出需求。

从这个角度来看,26年HBM增势回落的判断是相对客观的,但价值空间仍无可匹敌,与此同时D5的产能也有望复苏。

需求侧

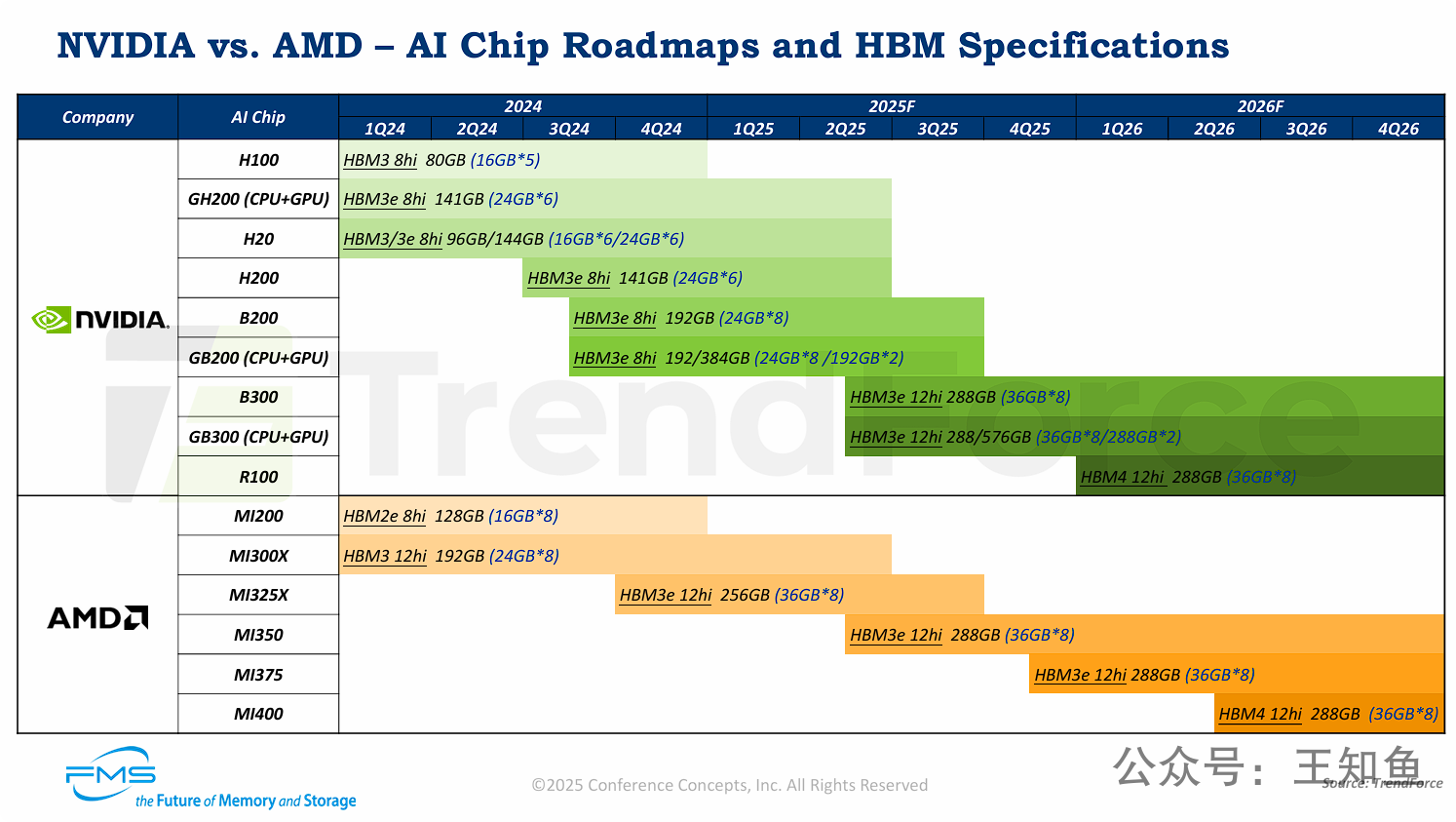

详细对比了NVIDIA和AMD两家公司的AI芯片产品路线图,时间跨度从2024年第一季度 (1Q24) 到2026年第四季度 (4Q26),重点是各芯片所搭载的HBM(高带宽内存)的规格。

-

HBM技术代际竞赛: HBM技术正在加速迭代。2024年是HBM3(AMD MI300X)向HBM3e(NVIDIA B系列, AMD MI325X)过渡的关键一年。而下一代HBM4预计将在2026年被双方的旗舰产品(NVIDIA R100, AMD MI400)采用。

-

HBM容量和堆叠层数激增: 为了满足AI大模型对内存容量和带宽的渴求,芯片商正在HBM的两个维度上“军备竞赛”:

-

堆叠层数: 从8hi(8层)升级到12hi(12层)已成趋势,以实现更高的单HBM Stack容量(从24GB提升到36GB)。

-

总容量: 双方的旗舰AI芯片HBM总容量正从2024年的192GB(B200, MI300X)跃升至2025-2026年的288GB(B300, MI350/MI400)。

-

-

产品对位与竞争白热化: 两家巨头的产品发布节奏紧密,规格针锋相对。

-

NVIDIA的B200(192GB)对标AMD的MI300X(192GB)。

-

NVIDIA的B300(288GB)对标AMD的MI350(288GB)。

-

双方预计都在2026年推出采用HBM4的下一代产品。

-

-

产品策略差异化: NVIDIA继续推进其纯GPU(如B300)和CPU+GPU集成的超级芯片(如GB300)两条战线,后者可提供翻倍的系统内存(如576GB)。AMD则专注于其MI系列加速卡。

[!note]

N厂GH/B 系列因 Grace CPU采用ARM架构,其能效比应该比AMD的x86还是要高出不少,但OEM整机围绕x86构建了30年的生态,短时间ARM仍不会成为OEM厂商的主流,但也能看到在非计算密集场景,也多了一些新的尝试。说明行业已逐步接受算力竞争的最后,将是残酷的能效比。

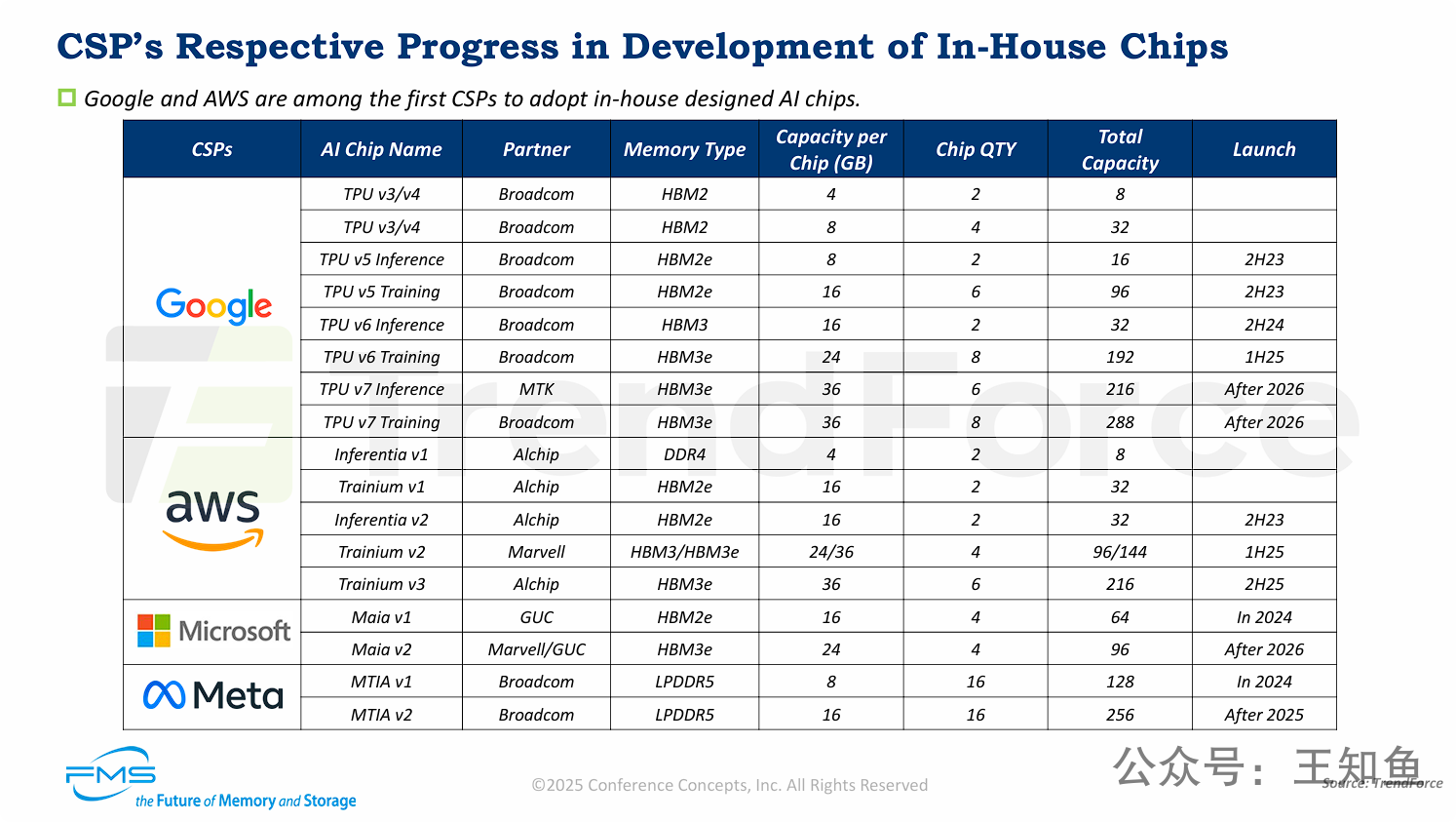

大型云服务提供商 (CSPs) 正在全面推进其自研AI芯片战略,以满足特定的工作负载需求并降低对NVIDIA等第三方供应商的依赖。

-

自研趋势确立: Google, AWS, Microsoft, Meta 四大巨头均已布局自研AI芯片,并有清晰的迭代路线图。

-

HBM成为主流标准: 对于面向训练和高性能推理的AI芯片(如Google TPU, AWS Trainium, Microsoft Maia),HBM(特别是HBM2e, HBM3, HBM3e)已成为标配内存,因为它们能提供AI大模型所需的高容量和高带宽。

-

内存容量持续攀升: 芯片的演进伴随着内存规格的快速升级。单芯片HBM容量正从16GB (HBM2e) 提升至24GB (HBM3),并将在2025-2026年后达到36GB (HBM3e)。

-

差异化内存策略: 并非所有CSP都选择HBM。Meta的MTIA芯片采用了LPDDR5内存,这是一种与HBM不同的技术路径,可能更侧重于成本、功耗或特定推理场景(如推荐系统)的优化。

-

生态合作紧密: CSP的自研芯片依赖于强大的半导体合作伙伴生态,包括Broadcom, Marvell, Alchip, GUC, 甚至MTK等。

[!note]

CSPs 布局自研芯片是早于GPT 3 公布之前(22年底)的,有大量内部运营分析报告指出,运行在数据中心的客户业务,仅使用20-30%的CPU利用率,从能耗和降本角度,促使CSPs 在很早就考虑引入ARM来降低基础设施的资本投入,同时扩展自身软件技术护城河。另外需要指出的是,自研芯片最成气候的 Google 和现在活跃在OCP组织的Meta 都选择 Broadcom 作为芯片设计伙伴,这也应召 David 在分析中评价 Broadcom 才是 NVIDIA 真正竞争对手这一判断,加速计算的核心的并行处理,并行的核心被抽象、锁定在片上互联和通信。

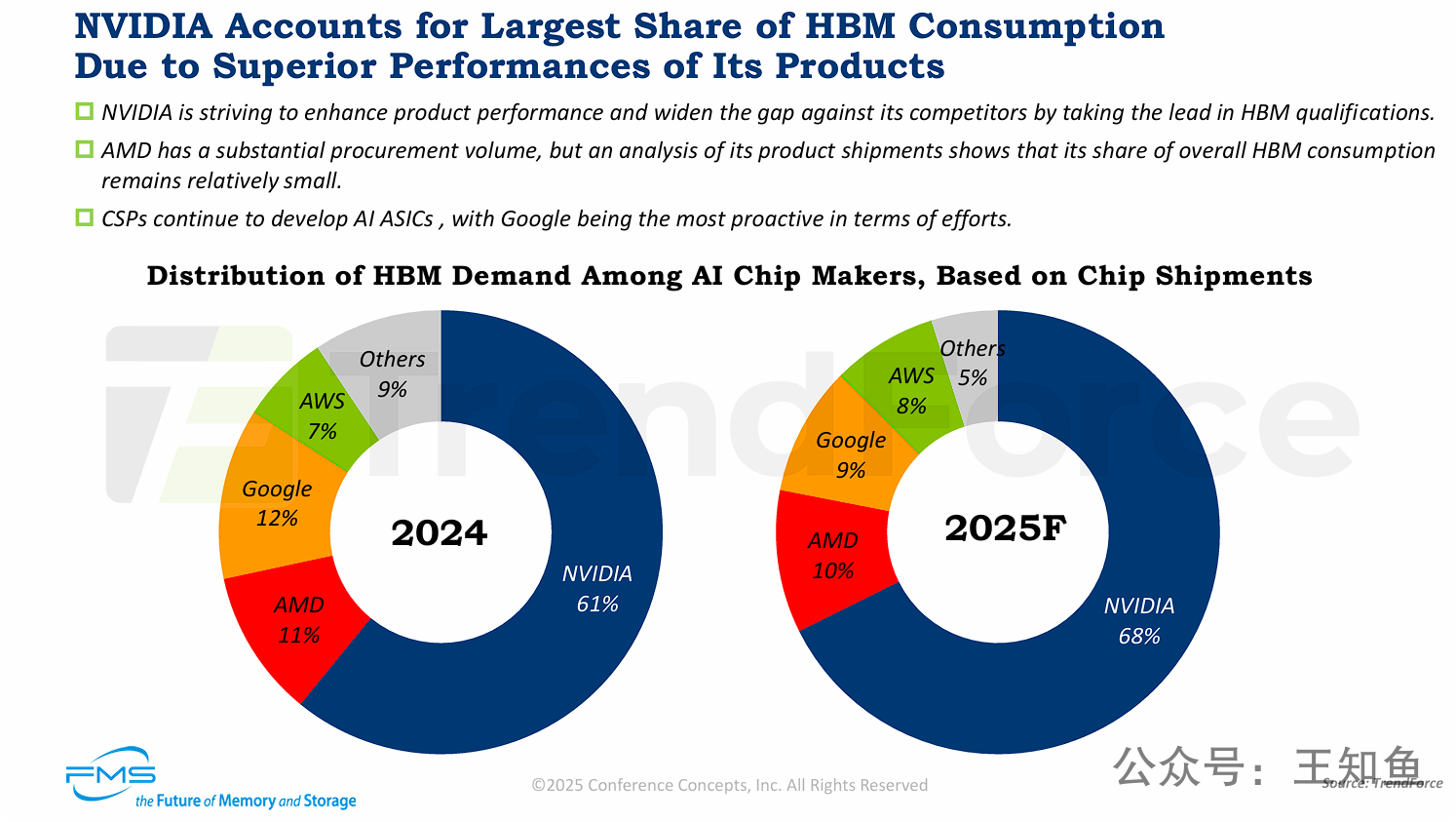

NVIDIA在AI芯片市场对HBM的消耗占据绝对主导地位,并且这一主导地位预计将在2025年得到进一步巩固。

-

NVIDIA的绝对霸主地位: 2024年,NVIDIA消耗了全球AI芯片用HBM的61%,预计到2025年,这一比例将增长到68%。

-

NVIDIA的竞争策略: NVIDIA通过其卓越的产品性能和在HBM技术认证上的领先(能优先获得和导入最新HBM),来甩开竞争对手。

-

竞争格局的变化:

-

AMD 和 Google 在2025年的HBM消耗份额预计都将有所萎缩。

-

AWS 份额保持基本稳定(略有增长)。

-

“其他”厂商的份额被NVIDIA等主要厂商挤压,市场集中度正在提高。

-

-

CSPs(云厂商)的角色: 尽管CSP(如谷歌和AWS)在积极自研芯片(如TPU和Trainium),但从HBM消耗量(代表高端AI芯片的出货量)来看,它们与NVIDIA的差距仍然巨大,甚至在2025年有所扩大。

[!note]

NVIDIA 成为这波AI浪潮全球资本的蓄水池,是各种原因促成的,占据这么大市场份额也是畸形的,且单一硬件厂商份额越大,市场泡沫也就越严重。NVIDIA描述的AI场景,不论是人形机器人、自动驾驶、虚拟现实大概率都是5-10年后的产品,当下最紧迫的需求是:头部企业、组织的数据资产变现和资本化,这些硬件暂时还解决不了问题,不能忽略数据平台软件层的创新!健康的市场,应该是云厂商扩大AI芯片采购,因为大量软件厂商的创新,仍基于云厂商上的数据资产,而不是 NeoCloud 向NVIDIA举债,来扩大NVIDIA 的市占率。

市值与营收

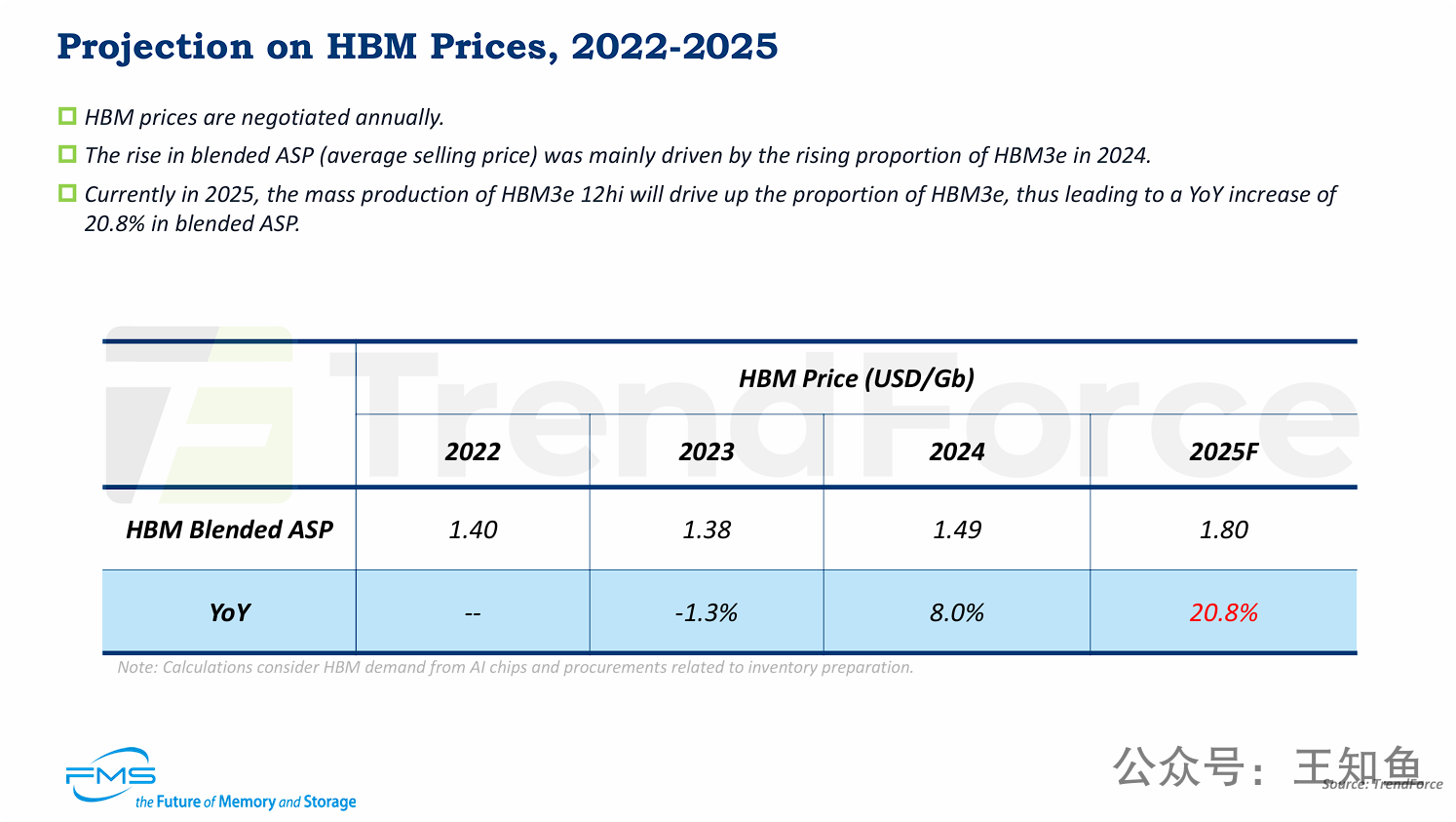

HBM的平均价格在经历2023年的短暂回调后,从2024年开始进入快速上涨通道,预计2025年将出现20.8%的显著涨幅。(材料分享于25年8月)

这一价格上涨的主要驱动力不是传统意义上的通货膨胀,而是产品结构的升级:

-

高端产品占比提升: 市场需求正从老一代的HBM(如HBM2e, HBM3)转向更昂贵、性能更强的新一代产品(HBM3e)。

-

技术复杂度增加: 2025年,HBM3e 12hi(12层堆叠)的量产将成为关键驱动因素。12层堆叠的制造成本和价值远高于8层堆叠,这直接拉高了整个HBM市场的“混合平均售价”(Blended ASP)。

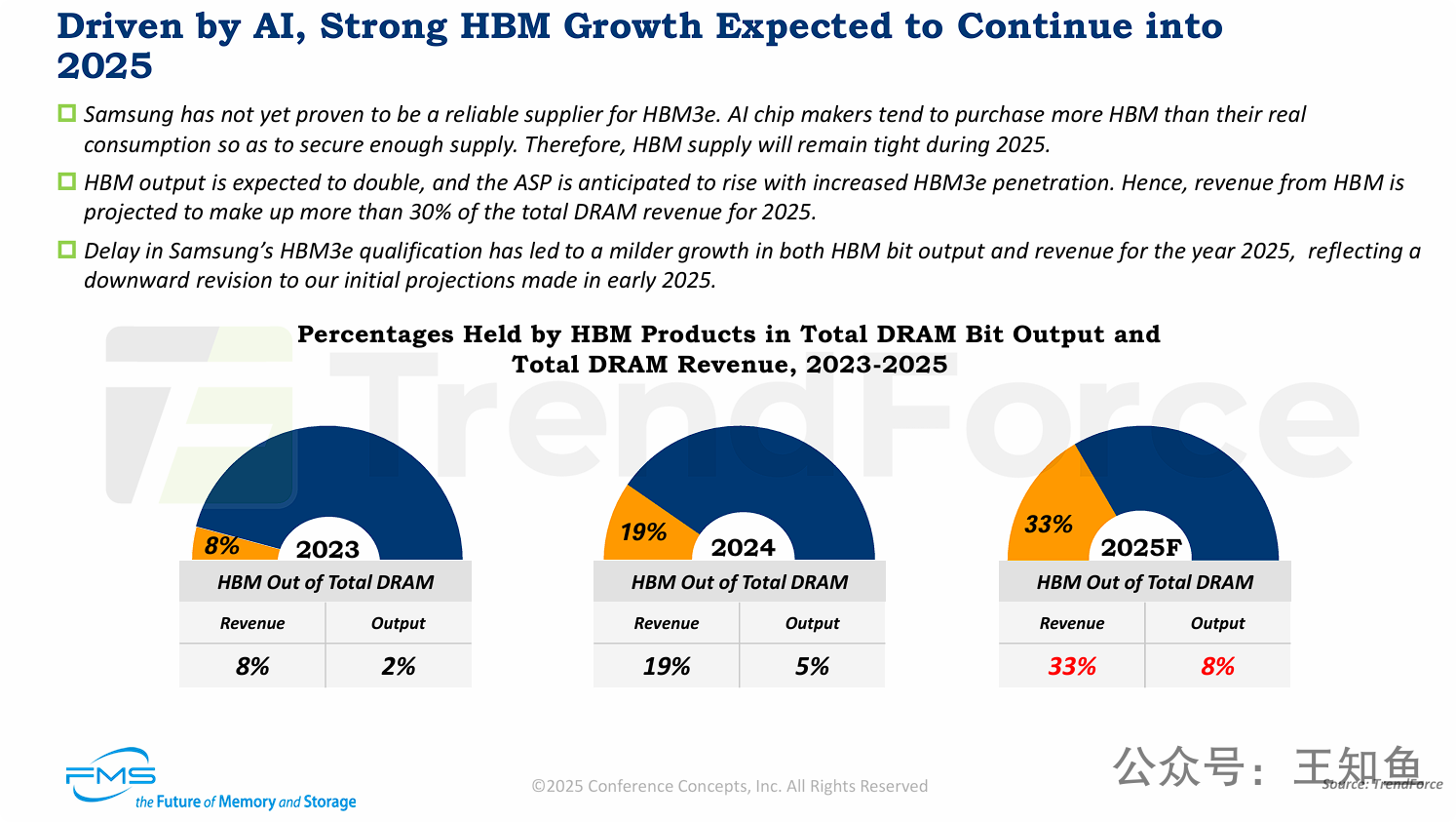

HBM正成为DRAM行业极其重要的收入支柱,其“价值”占比远超其“产量”占比,显示出极高的产品溢价。

-

价值与产量的巨大差异: HBM是一种高价值产品。预计到2025年,HBM的比特产出(产量)仅占DRAM总市场的8%,但其贡献的收入(价值)却将高达DRAM总收入的33%(即三分之一)。

-

HBM收入占比激增: HBM在DRAM总收入中的占比正从2023年的8%迅速攀升至2025年的33%,这得益于AI带来的强劲需求以及HBM3e等高端产品推动的ASP(平均售价)上涨。

-

供应持续紧张: 2025年的HBM市场供应将保持紧张。这背后有双重原因:一是需求端的AI芯片商超额预订以确保产能;二是供给端的三星(作为主要供应商之一)在关键的HBM3e产品上认证进度迟缓。

-

预测被下调: 尽管增长强劲,但2025年的实际增长预期(无论是产出还是收入)已经因为三星的认证延迟问题而被“向下修正”过,表明供应瓶颈已成为限制市场增长的关键因素。

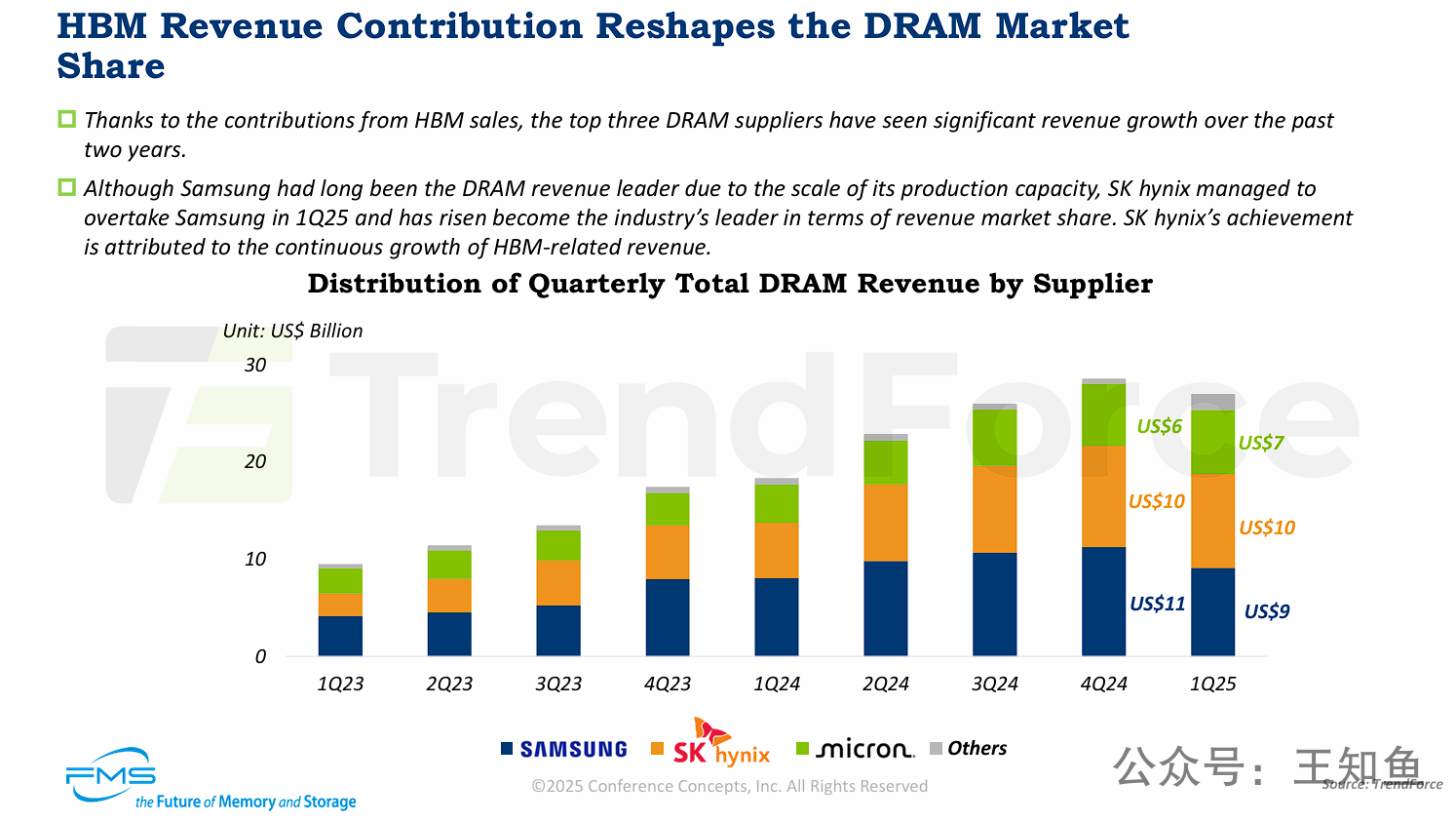

HBM正在引发DRAM市场领导地位的重大变革。

-

市场格局被颠覆: 传统上,三星凭借其庞大的产能规模,长期稳坐DRAM市场收入冠军。但这一格局在2025年第一季度被打破。

-

SK海力士登顶: 凭借在HBM市场(特别是HBM3和HBM3e)的领导地位和相关收入的爆炸式增长,SK海力士的DRAM总收入在2025年Q1(预测)成功超越三星,成为全球第一大DRAM供应商(按收入计算)。