亚洲内存市场:趋势与危机

问题意识

AI浪潮席卷全球,算力瓶颈已成过去?当数据中心电力消耗激增,各国纷纷布局“主权计算”,你是否意识到,真正的战场已悄然转向内存技术?本文将深入剖析全球半导体格局的战略性转变,揭示AI时代“内存主权”的深远意义,以及中韩等亚洲玩家如何重塑未来科技版图。

👉 划线高亮 观点批注

Main

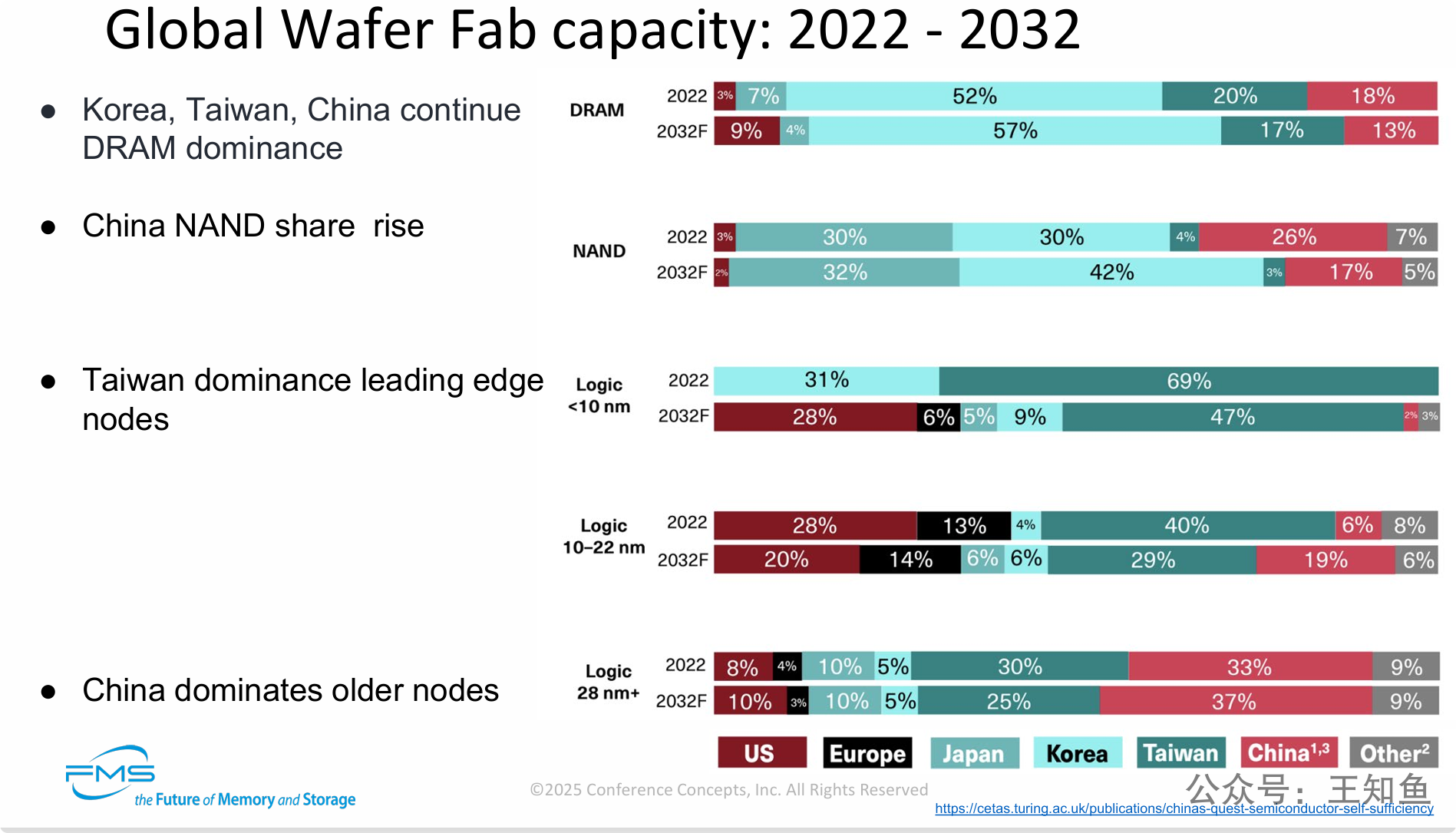

PPT通过对比2022年和2032年的全球晶圆厂产能数据,揭示了未来十年全球半导体制造业格局的重大战略性转变。其核心观点如下:

-

东亚在存储芯片领域的主导地位依然稳固:尤其是在DRAM和NAND市场,韩国的领导地位将得到空前加强,预计到2032年将在两个领域都占据最大份额。

-

先进制程逻辑芯片格局将重塑:虽然台湾在10纳米以下的最先进制程领域将继续保持领先,但其绝对主导地位将被削弱。最大的变量是US,得益于政策激励(如CHIPS法案),其产能份额预计将实现爆炸性增长,成为仅次于台湾的第二大玩家。这表明全球正在努力实现先进制程供应链的多元化。

-

CN在成熟制程领域的优势将进一步扩大:在28纳米及以上的成熟制程市场,CN目前已是领导者,预计到2032年其领先优势会进一步巩固,成为全球成熟制程芯片的主要供应基地。

-

全球半导体产能呈现战略分化趋势:整体来看,未来全球半导体产业布局将出现明显分化。以US为首的国家正大力投资,以夺回在先进制程逻辑芯片领域的制造份额;而CN则在巩固和扩大其在成熟制程和存储芯片市场的地位。这一趋势反映了地缘政治因素对全球半导体供应链的深刻影响。

===

具体内容分解如下:

-

DRAM (动态随机存取存储器)

-

图表数据:

-

2022年: 韩国以52%的份额占据绝对主导地位(三星、海力士是现有格局的巨头),其次是台湾(20%)和CN(18%)。

-

2032年预测: 韩国的份额将进一步增长至57%,继续扩大领先优势。台湾和CN的份额预计将分别下降至17%和13%。(国内份额下降这一趋势,或许有待商议,以GB为单位的容量市占,国内未来几年应该是上升的,但在高端领域的HBM、DDR5/6 存在较大差距)

-

-

-

NAND (闪存)

-

图表数据:

-

2022年: CN和韩国并驾齐驱,分别占据30%的份额,日本以26%紧随其后。

-

2032年预测: 韩国的份额将大幅增长至42%,成为NAND市场无可争议的领导者。CN的份额微增至32%,而日本的份额则大幅下降至17%。

-

-

-

Logic <10 nm (小于10纳米的先进制程逻辑芯片)

-

图表数据:

-

2022年: 台湾以69%的份额占据绝对垄断地位,韩国以31%位居第二。

-

2032年预测: 台湾的份额将下降至47%,但仍保持领先。最显著的变化是US,其份额将从几乎为零飙升至28%。韩国的份额则下降至9%。(A国芯片法案刺激本地建厂,受影响最大的是韩国)

-

-

-

Logic 10-22 nm (10-22纳米逻辑芯片)

-

图表数据:

-

2022年: 台湾以40%的份额领先,其次是CN(28%)和US(13%)。

-

2032年预测: 台湾和CN的份额将分别下降至29%和20%。日本的份额预计将大幅增长至19%,US的份额微增至14%。

-

-

-

Logic 28 nm+ (28纳米及以上的成熟制程逻辑芯片)

-

图表数据:

-

2022年: CN以33%的份额领先,台湾以30%紧随其后。

-

2032年预测: CN的领先优势将扩大,份额增至37%。台湾的份额则下降至25%。

-

-

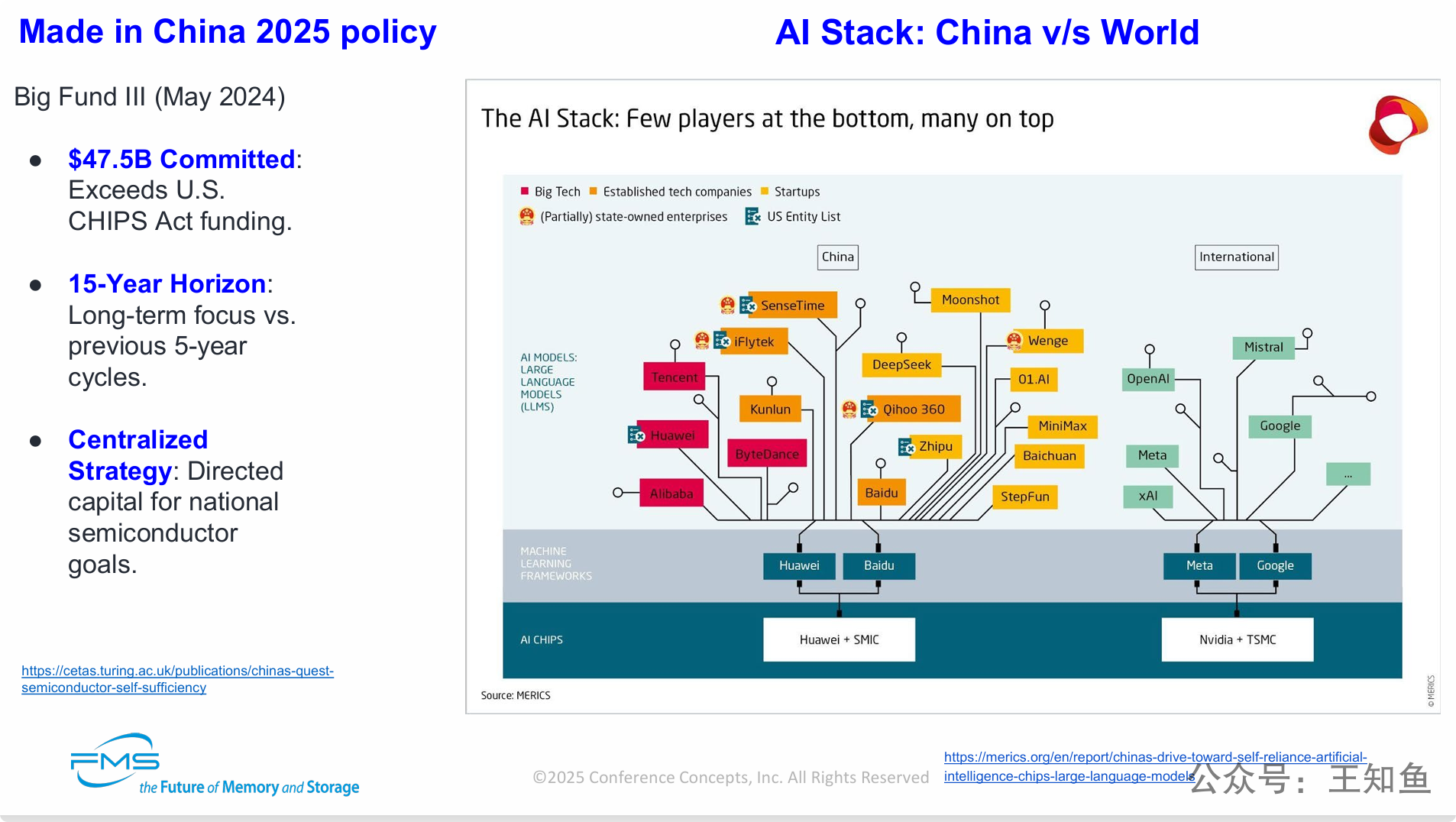

在全球AI竞赛中,CN正通过大规模、长周期的国家战略(大基金三期)力图构建一个独立自主的AI技术生态,以应对外部限制。然而,当前阶段仍存在对国际技术的严重依赖。

-

战略层面:国家意志驱动下的自主可控:左侧内容清晰地表明,CN正在以超越USCHIPS法案的投资力度,通过国家力量主导,旨在实现半导体和AI技术的自给自足。这是一个长达15年的宏大计划。

-

生态层面:两个平行的AI世界正在形成:右侧的AI技术栈图直观地展示了两个并行的生态系统。一个是CN主导的,从芯片(华为/中芯)到框架(华为/百度)再到上层模型的“国产栈”;另一个是国际主导的,从芯片(Nvidia/TSMC)到框架(Google/Meta)的“国际栈”。

-

现实挑战:CNAI发展对国际技术栈的依赖:图表最深刻的洞见在于,它揭示了CNAI产业的“双轨”现状。一方面,国家队和传统巨头在努力打造国产栈;另一方面,一批最具创新活力的CNAI创业公司(如月之暗面、零一万物、百川智能等)为了追求最高性能,其大模型产品目前仍构建在“国际栈”之上,深度依赖Nvidia的GPU和开源框架。

-

根本矛盾:自主雄心与技术现实的差距:PPT最终揭示了CNAI产业的核心矛盾——宏大的自主可控目标与当前技术发展路径依赖之间的差距。AI竞赛的终极瓶颈在于底层的AI芯片,而这正是CN“国产栈”目前最薄弱的环节。

===

图例 (Legend):

-

红色方块:大型科技公司 (Big Tech)

-

黄色圆形:初创公司 (Startups)

-

蓝色国旗方块:部分国有的企业 (Partially state-owned enterprises)

-

红色边框:被列入US实体清单的公司 (US Entity List)

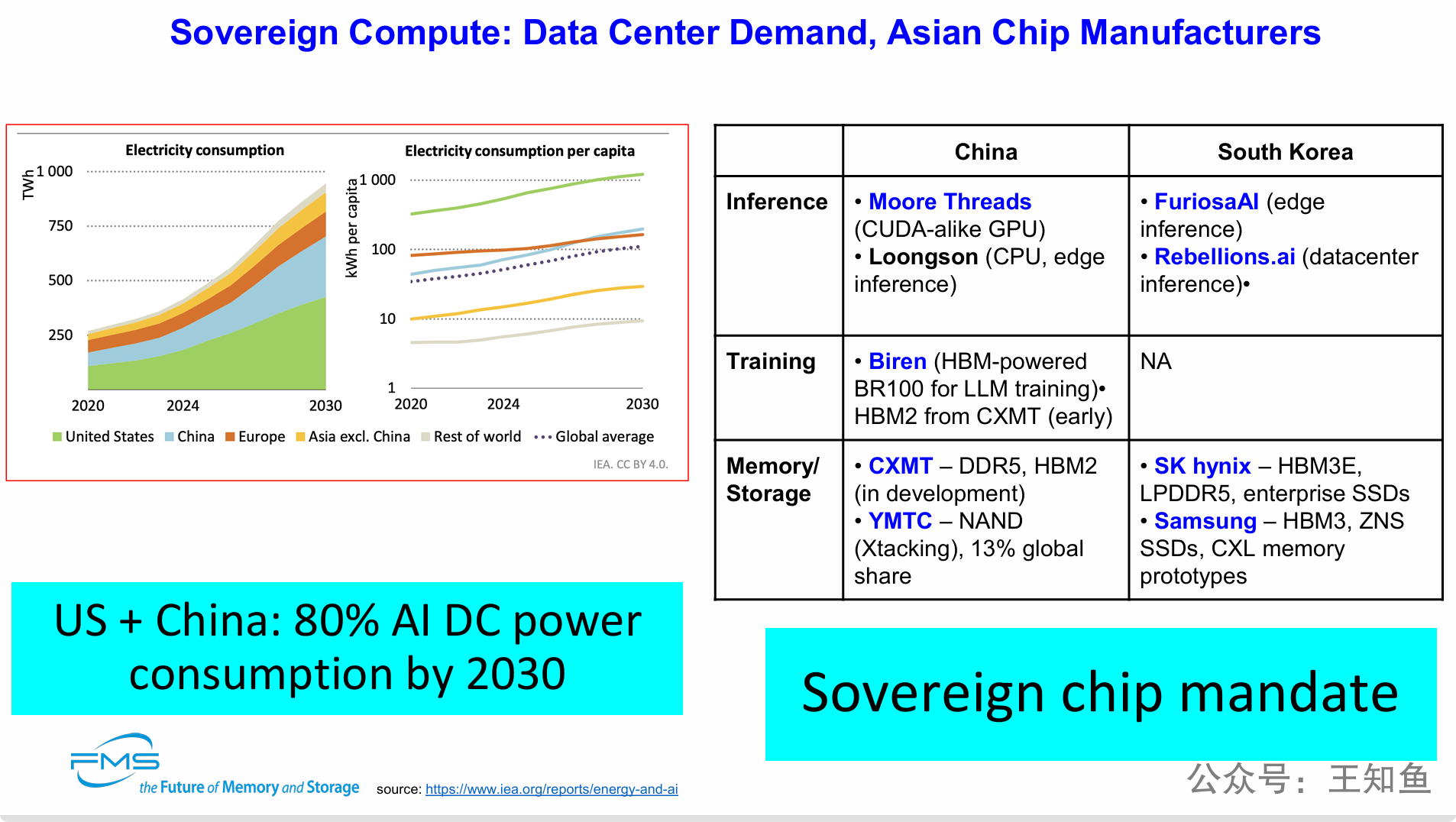

PPT分为两个主要部分:

1. 左侧:数据中心需求 (Data Center Demand) 这部分通过两张图表展示了全球数据中心(包括AI和加密货币)电力消耗的增长趋势,数据来源为国际能源署(IEA)。

-

总电力消耗图 (Electricity consumption):

-

这张堆叠面积图展示了从2020年到2030年的总电力消耗(单位:TWh,太瓦时)。

-

预测显示,全球数据中心的电力消耗(2026之后)将急剧上升。其中,US和CN的增长最为迅猛,是全球数据中心能耗增长的主要驱动力。

-

-

人均电力消耗图 (Electricity consumption per capita):

-

这张折线图按人均(单位:kWh/人)展示了电力消耗情况。

-

图表显示,US的人均数据中心电力消耗远高于世界其他地区,并且预计未来差距会进一步拉大。

-

-

核心结论:

- 左下角的蓝色方框总结了图表的关键信息:“US + China: 80% AI DC power consumption by 2030” (到2030年,US和CN将占全球AI数据中心电力消耗的80%)。这凸显了AI计算资源需求的地理高度集中性。

2. 右侧:亚洲芯片制造商 (Asian Chip Manufacturers) 这部分通过一个表格,对比了CN和韩国在AI相关芯片领域的关键企业和技术布局,涵盖了推理、训练和内存/存储三个核心环节。

-

推理 (Inference):

-

CN: 摩尔线程 (Moore Threads),开发类CUDA的GPU;龙芯 (Loongson),CPU及边缘推理芯片。

-

韩国: FuriosaAI,专注于边缘推理;Rebellions.ai,专注于数据中心推理。

-

-

训练 (Training):

-

CN: 壁仞科技 (Biren),其BR100芯片采用HBM(高带宽内存)为大语言模型(LLM)训练提供支持。

-

韩国: NA (Not Applicable),表格显示韩国在高端AI训练芯片领域暂无成熟的本土厂商。

-

-

内存/存储 (Memory/Storage):

-

CN: 长鑫存储 (CXMT),生产DDR5和早期的HBM2;长江存储 (YMTC),专注于NAND闪存,拥有Xtacking技术,并占据13%的全球市场份额。

-

韩国: SK海力士 (SK hynix),提供HBM3E、LPDDR5和企业级SSD;三星 (Samsung),提供HBM3、ZNS SSD和CXL内存原型。这部分凸显了韩国在先进内存技术(尤其是AI必需的HBM)方面的绝对领先地位。

-

-

核心概念:

- 右下角的蓝色方框 “Sovereign chip mandate” (主权芯片指令),点明了这些国家发展本土芯片产业背后的驱动力是确保国家技术主权和供应链安全的战略任务。

PPT核心观点:

由AI引发的数据中心算力需求爆炸式增长,正在催生一场以国家为主导的“主权计算”竞赛,而亚洲的芯片制造商是这场竞赛的核心参与者。

-

需求是核心驱动力:AI应用导致数据中心的电力和算力需求急剧膨胀,并且这种需求高度集中在US和CN。巨大的市场需求为本土芯片产业的发展提供了强大的牵引力。

-

“主权计算”成为国家战略:面对算力需求的激增和地缘政治的不确定性,发展自主可控的芯片产业(即“主权芯片”)已成为关键国家的国家级战略任务,以保障其数字经济和国家安全。

-

中韩两国战略路径分化:

-

CN正在寻求建立一个 “全栈式” 的本土AI芯片生态系统,努力覆盖从训练(壁仞科技)、推理(摩尔线程)到存储(长江存储、长鑫存储)的各个环节,意图全面替代国外技术。

-

韩国则采取 “扬长避短” 的策略,依托其在全球存储领域的绝对优势(三星和SK海力士的HBM内存是AI训练芯片的关键组件),巩固其在AI价值链中不可或缺的地位,同时也在AI推理芯片等新兴领域积极布局初创公司。

-

-

关键技术差距依然存在:表格清晰地揭示了,尽管CN在各领域均有布局,但在最尖端的技术环节(如用于AI训练的高性能GPU和最先进的HBM内存)与国际领先水平仍有差距。而韩国在AI训练芯片这一核心计算领域存在明显短板。

表格内容逐项解析:

| 类别 (Category) | 长鑫存储 (CXMT - ChangXin Memory) | 长江存储 (YMTC - Yangtze Memory) |

|---|---|---|

| 产品焦点 (Product Focus) | DRAM (从DDR4演进到DDR5), HBM2/3E | 3D NAND (294层, 采用XStacking架构) |

| 生产规模 (Production Scale) | 预计到2025年底达到每月28-30万片晶圆 | 约每月25万片晶圆产出(WOPM);每月使用约50万片原始晶圆 |

| 技术节点 (Technology Node) | 16nm (1z工艺);大约落后行业领导者3-4年 | 距离行业领导者(三星、美光)仅约1-2年差距 |

| HBM状态 (HBM Status) | HBM2已于2024年底投产;计划2026年推出HBM3 | 未涉足HBM业务;专注于先进NAND闪存 |

| 市场份额 (Market Share) | 从0%(2020年) → 5%(2023年) → 预计2025年达到10-12% | 在2024-2025年间,全球NAND市场份额达到13% |

| 战略角色 (Strategic Role) | 为“主权计算”提供DRAM的潜在供应商 (例如为壁仞科技等) | 静默扩张,进入高密度AI存储市场;作为西方闪存的替代选择;在HBF(混合键合)领域具备领导力 |

| 受制裁风险 (Sanctions Exposure) | 使用16nm技术,刚好在US出口管制的门槛之上 | 已被列入US实体清单;易受出口管制收紧的影响 |

===

PPT深入剖析了在CN追求技术自主的国家战略背景下,其两大存储芯片企业——长鑫存储和长江存储——所扮演的角色、发展路径和面临的挑战。核心观点可以总结为以下几点:

-

国家战略是根本驱动力:PPT开宗明义地指出,CN发展本土存储产业的首要动力是实现技术自主和供应链安全的国家意志(“主权任务”),这为两家公司的发展提供了巨大的政策支持和市场空间。

-

“双雄”分工,路径不同:CN采取了专业化分工的策略,由长鑫存储主攻DRAM内存,长江存储主攻NAND闪存。

-

长江存储(YMTC) 在技术上更接近世界前沿(仅落后1-2年),并已占据可观的全球市场份额(13%)。它的战略角色是成为高密度AI存储领域中非西方技术的重要替代者。

-

长鑫存储(CXMT) 在DRAM技术上与世界巨头差距较大(落后3-4年),但其市场份额正在快速增长。它的核心战略任务是为CN本土的“主权计算”生态(如国产AI芯片)提供关键的DRAM内存,保障供应链安全。

-

-

积极布局AI,但侧重不同:面对AI带来的巨大机遇,两家公司策略不同。长鑫存储正积极研发对AI算力至关重要的HBM(高带宽内存),计划推出HBM2/3,这是支持国产AI芯片发展的关键一步。而长江存储则选择聚焦自身优势,为AI应用提供高性能、高密度的大容量NAND闪存。

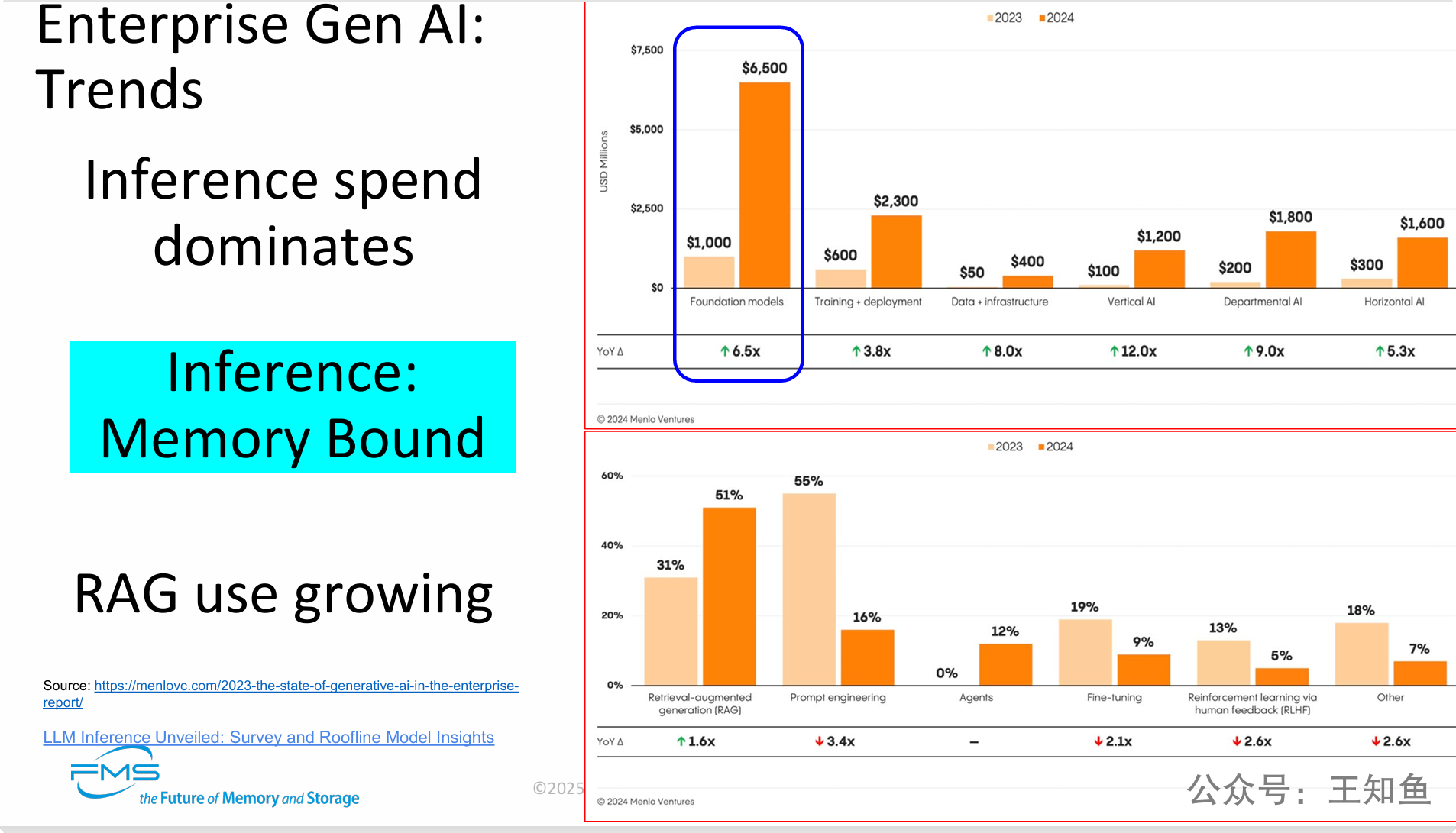

右侧数据图表:

共有两张图表,均对比了2023年和2024年的数据。

-

图表一:企业生成式AI支出分布 (单位:百万美元)

-

该图表展示了企业在Gen AI不同领域的预计支出。

-

基础模型 (Foundation models): 支出从2023年的10亿美元飙升至2024年的65亿美元,年同比增长6.5倍。这是所有类别中最大的一块支出,印证了“推理支出占主导地位”的观点,因为这部分费用主要用于购买模型API的调用服务。

-

训练与部署 (Training + deployment): 从6亿美元增长到23亿美元 (增长3.8倍)。

-

垂直领域AI (Vertical AI): 从1亿美元增长到12亿美元 (增长12.0倍),显示出行业专用AI的巨大增长潜力。

-

其他类别如数据与基础设施、部门级AI和通用AI也均有显著增长。

-

-

图表二:企业生成式AI技术采用率

-

该图表展示了各项Gen AI技术的企业采用率百分比。

-

检索增强生成 (RAG): 采用率从2023年的31%大幅增长至2024年的51%,年同比增长1.6倍。这一显著增长直接证实了“RAG使用正在增长”的结论,表明RAG已成为企业应用AI的主流技术之一。

-

提示工程 (Prompt engineering): 采用率从55%大幅下降至16%。大模型thinking能力快速提升,提示词工程的需求降低

-

智能体 (Agents): 从0%增长到12%,是一项新兴且快速发展的技术。

-

微调 (Fine-tuning) 和 基于人类反馈的强化学习 (RLHF) 也有稳步增长。

-

===

这张PPT揭示了企业级Gen AI市场正在从“技术探索”转向“价值落地”阶段,并呈现出三个明确的核心趋势:

-

成本重心从训练转向推理:企业AI的经济账已经清晰,一次性的模型训练成本远不及长期、高频的模型使用(推理)成本。高达65亿美元的基础模型支出(主要是API调用费用)表明,如何优化推理的成本和效率已成为企业AI战略的核心议题。

-

技术瓶颈从算力转向内存:“推理是内存密集型(Memory Bound)”的判断至关重要。这意味着,单纯堆砌GPU算力已不足以解决推理的性能问题,高速、大容量的内存(如HBM、DDR5)和高效的数据存储成为了新的关键瓶颈。这对整个硬件和存储行业都提出了新的要求和机遇。

-

应用模式从通用转向专用(RAG驱动):RAG技术的爆炸性增长(采用率从31%到51%)标志着企业正在将AI从“通用聊天机器人”转变为解决实际业务问题的工具。通过RAG,企业能让大模型利用自身的私有数据(如产品文档、客户记录、知识库)提供精准、可靠的回答,这是实现AI商业价值的关键路径。

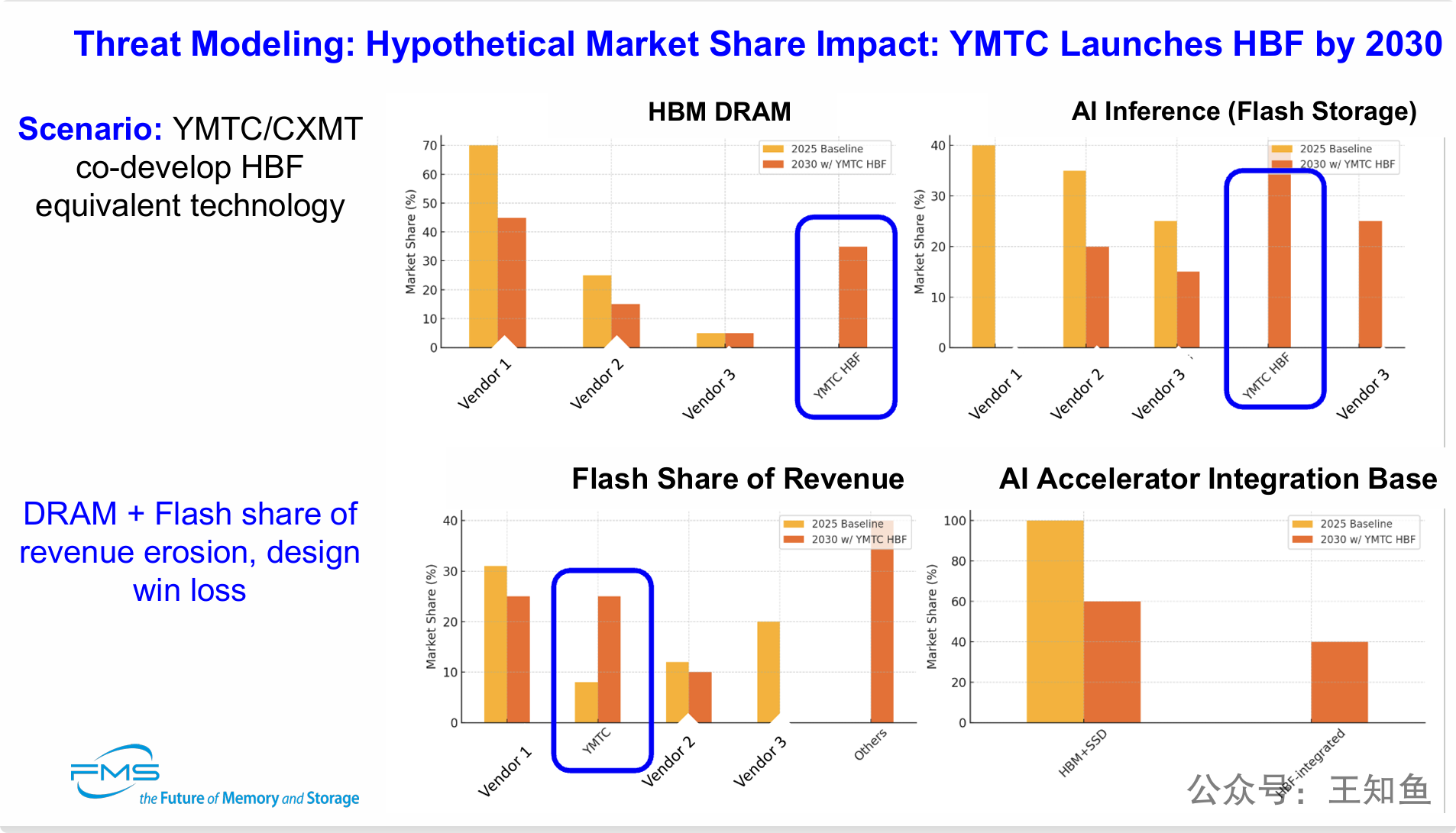

核心设定与预测:

-

场景 (Scenario): 长江存储(YMTC)与长鑫存储(CXMT)合作开发出与HBF等效的技术。这个前提是CN两大存储巨头联手,在2030年前实现技术突破。下一张PPT介绍HBF技术

-

影响 (Impact): DRAM + Flash 市场份额和收入被侵蚀,设计导入失败。这预言了如果该场景发生,现有市场领导者将面临收入下滑和在客户新产品设计中落选的双重打击。

四张图表的详细数据分析:

每张图表都对比了两种情况:橙色条代表“2025年基线”(2025 Baseline),红色条代表“2030年YMTC推出HBF后的情况”(2030 w/ YMTC HBF)。

-

HBM DRAM 市场份额:

-

基线: Vendor 1(厂商1)占据约70%的绝对主导地位。

-

2030年场景: Vendor 1的份额被大幅侵蚀至45%左右。同时,一个全新的类别 “YMTC HBF” 凭空出现,并夺取了高达35%-40%的市场份额。这表明HBF技术将直接挑战并替代现有HBM的市场。

-

-

AI推理 (闪存) 市场份额:

-

基线: Vendor 1、2、3共同瓜分市场。

-

2030年场景: “YMTC HBF” 成为市场领导者,占据约35%的份额,而原有的市场领导者Vendor 1和Vendor 2的份额均出现显著下滑。

-

-

闪存收入份额 (Flash Share of Revenue):

-

基线: YMTC约占12%的市场份额。

-

2030年场景: YMTC的收入份额飙升至约30%,超越所有竞争对手,成为市场第一。这说明HBF技术的成功将直接转化为巨大的商业成功。

-

-

AI加速器集成基础 (AI Accelerator Integration Base):

-

基线: 2025年,几乎100%的AI加速器采用的是“HBM内存 + SSD闪存”的传统架构。

-

2030年场景: 传统架构的采用率下降到60%。一种全新的“HBF集成” (HBF-integrated) 架构出现,并占据了40%的市场。这是最具颠覆性的一点。

-

===

PPT核心观点:

CN存储厂商可能通过一种名为HBF的颠覆性技术,绕开现有赛道,对全球高端存储市场格局造成根本性冲击。

-

威胁的核心是“降维打击”而非“线性追赶”:PPT所模拟的威胁,并非YMTC在传统NAND或HBM赛道上追平对手,而是通过一种全新的集成技术(HBF),创造出一个新物种。这个新物种同时具备了高性能内存和高密度存储的特性,从而对HBM和AI SSD两个独立市场同时构成威胁。

-

颠覆的根基是改变“系统架构”:最具战略性的洞察来自“AI加速器集成基础”图表。HBF的真正威力在于它能改变AI硬件的底层设计范式。它不再是简单地作为内存或硬盘被“连接”到处理器上,而是能够与AI芯片“集成”在一起,形成更高带宽、更低延迟、更小尺寸的解决方案,从而颠覆目前主流的“HBM+SSD”架构。

-

市场影响是全面且致命的:如果这一场景成真,其影响将是系统性的。现有的HBM和企业级SSD市场的领导者将面临高达30%-40%的市场份额损失。更重要的是,他们可能会输掉未来十年AI硬件架构的“设计话语权”。

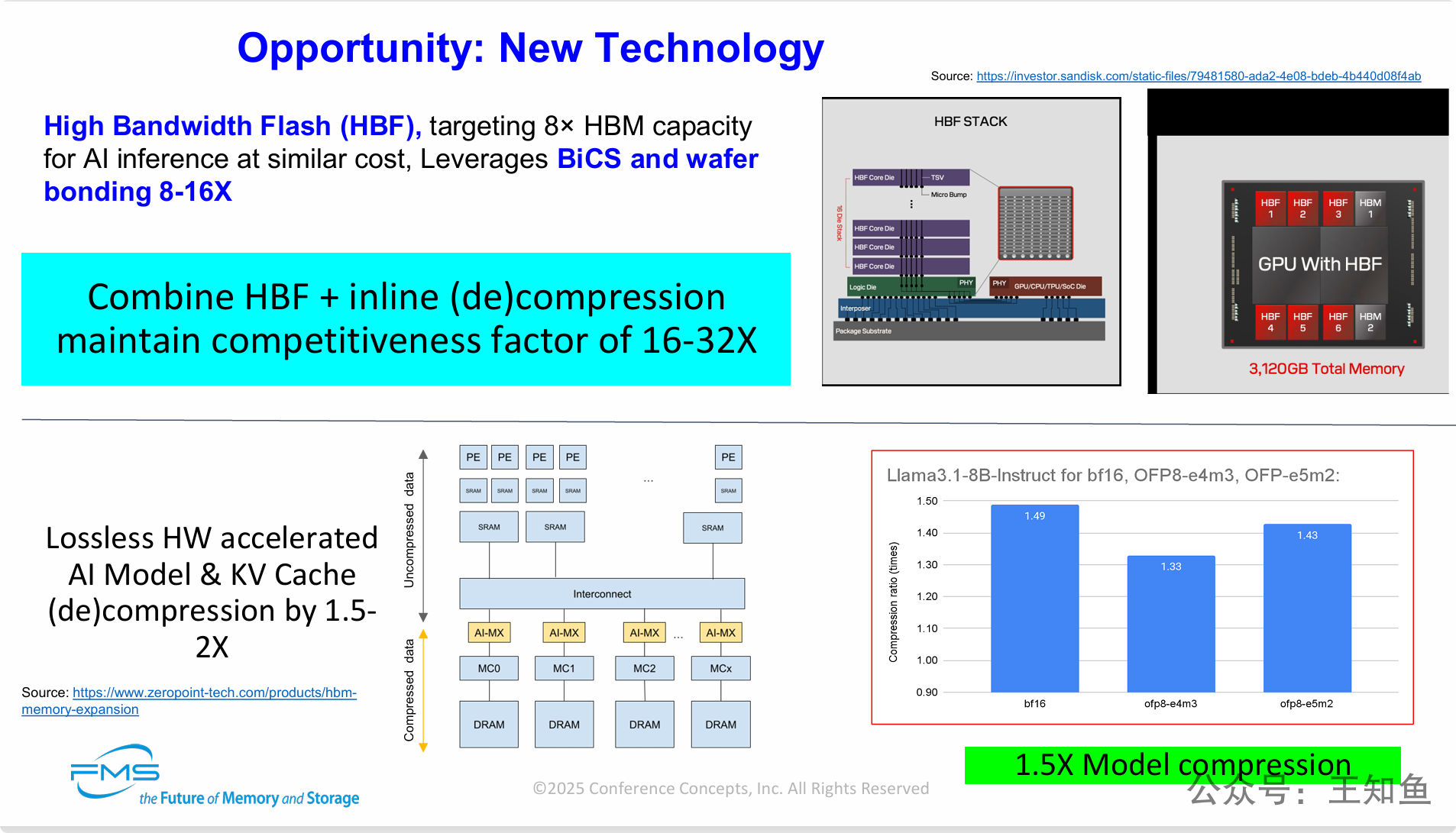

第一部分 (上部): 高带宽闪存 (High Bandwidth Flash - HBF)

-

核心定义:

-

HBF是一种专为AI推理设计的新型存储技术。

-

其目标是在相似成本下,提供8倍于HBM(高带宽内存)的容量。

-

它利用了BiCS(一种3D NAND闪存技术)和晶圆键合(wafer bonding)技术,实现了8到16层的闪存堆叠。

-

第二部分 (下部): 硬件无损压缩技术

-

左下角: 技术说明与架构

-

核心定义: 这是一种通过专用硬件加速的无损压缩技术。

-

应用对象: 专门用于压缩AI模型本身以及在推理过程中占用大量内存的KV Cache(键值缓存)。

-

效果: 可以实现1.5倍到2倍的实时(de)压缩率,相当于将内存容量和带宽凭空扩大了1.5-2倍。

-

架构图: 展示了非压缩数据流入,经过包含AI矩阵(AI-MX)和SRAM的硬件互连模块,压缩后存入DRAM的过程,反之亦然。这表明它是一个紧密集成在内存子系统中的硬件解决方案。

-

-

右下角: 数据验证

-

图表: 展示了对Llama3.1-8B模型使用不同数据格式进行压缩的效果,压缩比达到了1.33倍至1.49倍。

-

结论: 绿框总结为 “1.5X Model compression” (1.5倍模型压缩),为硬件压缩技术的效果提供了数据支持。

-

第三部分 (核心结论 - 蓝色方框)

-

“Combine HBF + inline (de)compression maintain competitiveness factor of 16-32X” (结合HBF与在线(解)压缩,可维持16-32倍的竞争力系数)。

-

这是整张PPT的点睛之笔。它指出,将HBF提供的8-16倍原始容量优势,与硬件压缩提供的2倍有效容量优势相乘,可以最终实现相对于纯HBM方案 16到32倍的惊人有效容量优势。

===

PPT核心观点:

通过HBF(硬件扩容) 和硬件压缩(软件/算法扩容) 这两种技术的战略性结合,可以系统性地解决当前大模型AI推理面临的“内存墙”瓶颈。

-

HBF:颠覆性的“容量层”解决方案:HBF并非HBM的简单替代品,而是一种全新的架构创新。它作为与HBM并存的海量“近内存”容量层,能够以可接受的成本将AI加速器上的内存从GB级别提升至TB级别,这使得在单芯片上直接运行超大模型成为可能。

-

硬件压缩:免费的“性能倍增器”:实时、无损的硬件压缩技术,相当于在不改变任何物理硬件的情况下,将现有内存的容量和有效带宽“免费”提升了1.5到2倍。它专门针对AI模型和KV Cache这两个内存消耗大户,精准解决了推理过程中的核心痛点。

-

协同效应:1+1 > 2的指数级突破:本张PPT最核心的洞见在于揭示了这两项技术的协同价值。单一技术只能带来线性提升,但将HBF的物理容量优势与硬件压缩的逻辑容量优势相结合,可以创造出16倍到32倍的巨大领先优势。这不仅仅是量的提升,更是可能引发AI硬件架构变革的质变,代表着一个巨大的市场机遇。

核心技术与架构解析:

-

什么是“SmartMem”智能内存 (右上角图解):

-

它不仅仅是存储芯片,而是一个被称为 “NuMem AI内存引擎” 的智能系统。

-

其核心包含一个 RISC-V处理器,以及数据管理、压缩技术、内存管理等硬件逻辑单元。

-

这个“引擎”与专有的MRAM存储阵列和优化算法相结合,构成一个完整的智能内存Chiplet(小芯片)。

-

本质上,这是一种计算内存 (Computational Memory) 或 内存内处理 (Processing-in-Memory, PIM) 技术,让内存从被动的存储单元变成了可以主动管理和处理数据的主动单元。

-

-

物理实现方式 (中间架构图):

-

该图展示了“SmartMem”可以像HBM一样,通过3D堆叠的方式与SoC(系统级芯片)集成在一起。

-

多层包含“SmartMem”引擎的NuRAM芯片堆叠起来,通过高速物理接口(PHY)与SoC上的内存控制器相连。

-

-

技术路线图 (左上角文字):

-

第一代 (Gen 1): 采用12nm工艺,可实现2-6 TB/s的带宽,每堆栈容量为3-9GB。

-

第二代 (Gen 2): 采用5nm工艺,带宽提升至4-12 TB/s,每堆栈容量增至8-16GB。

-

这些数据显示了其极高的性能潜力。

-

===

PPT核心观点:

通过引入带有计算能力的“智能内存”(Managed MRAM),可以解锁全新的AI系统架构,并解决现有存储技术的瓶颈。

-

内存的智能化革命:核心创新在于将计算能力(RISC-V处理器和AI算法)植入MRAM,创造出“AI内存引擎”。这使得内存从一个被动的“仓库”进化成了一个可以主动优化数据存取、执行压缩等任务的“智能管家”。

-

作为独立技术,价值巨大:即使独立使用,这种智能内存也能通过其内建的硬件压缩功能,带来立竿见影的5倍性能/容量优势,极具竞争力。

-

终极目标:构建多层级智能存储体系:其最具颠覆性的应用是与HBF协同工作。它完美地解决了HBF“容量大但速度稍慢”的短板。“SmartMem”(MRAM层)负责速度和智能管理,而“HBF”(闪存层)负责海量容量和成本控制。二者结合,形成了一个性能强大、成本可控、容量巨大的多层级(Hierarchical)智能存储解决方案。

-

未来AI硬件架构的雏形:这个“SmartMem + HBF”的组合,描绘了未来AI硬件存储系统的一个可能演进方向——不再是单一存储技术的单打独斗,而是多种存储介质在智能引擎的统一管理下,协同合作,各展所长。

PPT核心观点:

面对日益增长的内存需求和高昂的DRAM成本之间的矛盾(即“内存墙”问题),智能化的内存分层技术是关键的解决方案。PPT展示了两种不同但互补的技术路径:

-

AI软件定义路径 (面向企业):通过先进的AI软件算法,智能地调度和管理现有的硬件(DRAM和NVMe闪存),“欺骗”操作系统,让慢速存储设备表现得像快速主内存一样。这是一种以软件为核心的优化方案(MemVerge/UCM/CSAL等)。随着GDS/NVMe 的快速发展,高性能SSD对AI系统的补充作用将逐渐发挥出来。

-

硬件标准定义路径 (面向超大规模数据中心):通过CXL这一新的硬件互联标准,从物理上构建出层次分明、可扩展的内存池。这种方案的核心是硬件创新,它允许服务器突破主板上内存插槽的限制,连接巨大的外部内存资源。

-

两大关键使能技术:CXL与压缩:在超大规模解决方案中,CXL协议是构建分层内存的 “高速公路”,解决了连接和访问的瓶颈。而内存压缩技术则是 “空间魔法” ,它能在不牺牲过多性能的前提下,将物理内存容量倍增,是进一步降低成本、提升内存密度的关键。

左侧:Summary (现状总结)

这部分概括了当前全球计算和存储领域的宏观趋势。

-

主权计算不是一个趋势,而是全球计算经济学的重构 (Sovereign computing is not a trend — it's a restructuring of global compute economics):

- 这强调了“主权计算”(即国家力求建立自主可控的计算能力)并非短暂的风口,而是一场影响深远的、根本性的全球产业格局重塑。

-

亚洲在电力供应、芯片制造规模化、内存创新方面领先 (Asia leads in power availability, chip fab scaling, memory innovation):

- 这指出了当前竞争格局的现实——亚洲(特指之前提到的CN、韩国、台湾等)在支撑未来AI发展的几大基石领域已占据优势地位,包括:为数据中心提供充足电力的能力、扩大芯片制造产能的规模,以及在存储技术(如HBM, HBF)上的创新能力。

右侧:Action (行动建议)

这部分针对上述总结,提出了明确且紧急的应对策略。

-

US和欧盟必须立即行动:投资NAND/HBM/CXL/HBF生态系统,否则将变得依赖他人 (US & EU must act now: invest in NAND/HBM/CXL/HBF ecosystems or become dependent):

- 这是一个直接的行动呼吁。面对亚洲的领先态势,欧US家必须立刻对下一代存储(NAND)、内存(HBM)、互联技术(CXL)以及颠覆性技术(HBF)的完整生态链进行战略投资,否则将在未来AI时代的关键硬件上受制于人。

-

需要深度技术合作:整合内存、存储、IP、软件以有效应对威胁 (Deep tech collaboration required: Memory, storage, IP, software to effectively address threats):

- 这强调了仅有资金投入是不够的。为了构建有竞争力的生态并应对潜在的技术颠覆威胁,必须在整个技术栈上进行深度合作,涵盖硬件(内存、存储)、知识产权(IP)和软件等所有层面。

===

PPT核心论点:

全球正处在一场由“主权计算”驱动的深刻变革中,而这场变革的焦点已经从算力转向了内存。

-

时代变了:主权计算重塑格局,亚洲占据先机。全球技术竞争不再是纯粹的商业行为,而是上升到了国家战略层面。在决定未来AI基础设施成败的关键要素(能源、制造、内存创新)上,亚洲已经取得了领先优势。

-

西方的警钟:要么投资,要么依赖。面对这一不可逆转的趋势,欧US家已经没有退路。必须立即采取行动,通过大规模投资和深度产业协作,建立起独立自主的下一代内存技术生态,这是避免在未来陷入战略被动的唯一途径。

-

最终洞见:“内存即主权”。整个PPT系列最终导向一个颠覆性的结论:我们已经进入一个“内存为王”的时代。AI的未来不再仅仅取决于你有多少算力,更取决于你拥有何种内存、以及你是否能掌控它。“内存主权”(Memory Sovereignty)已经取代了单纯的“算力”,成为衡量一个国家在AI时代核心竞争力的最终标准。